СПЕЦИАЛИСТЫ ПО ВИЗУАЛИЗАЦИИ ДАННЫХ

Это люди с развитым чувством прекрасного, которые создают инфографику, дашборды и другие графические элементы. Кроме того, они могут заниматься написанием программного кода при помощи JavaScript, CoffeeScript, CSS и HTML и работают с библиотеками визуализации данных, такими как D3 (эффективная и красивая библиотека визуализации, описанная в книге Скотта Мюррея Interactive Data Visualization for the Web) и HTML5.

Джим (Джим В.) получил степень магистра в области теории и практики вычислительных систем со специализацией в сфере биоинформатики и машинного обучения. Он работал в компании Garmin, где создавал графические пользовательские интерфейсы для навигационных устройств. После этого в биологическом научно-исследовательском институте он проводил анализ масштабной последовательности данных. Именно тогда он познакомился с библиотекой визуализации данных D3 и начал вести блог, посвященный этой теме, где публикует доступные и понятные руководства для пользователей. Сегодня Джим занимает пост специалиста по визуализации данных и специалиста по теории и методам анализа данных в лаборатории данных корпорации Nordstrom в Сиэтле. В своей работе он использует такие инструменты, как Ruby, Python и среду R (в частности пакеты ggplot2 и dplyr). Он обеспечивает поддержку систем персонализации и рекомендаций, а также осуществляет визуализацию данных. Основными его «клиентами» становятся сотрудники из других подразделений компании. В крупных компаниях иногда могут быть дополнительные специалисты, которые занимаются исключительно подготовкой отчетов или применением определенного инструмента бизнес-аналитики. Другие специалисты могут работать только с инструментами обработки и анализа больших данных, например Hadoop или Spark.

4

1

Голос

Рейтинг статьи

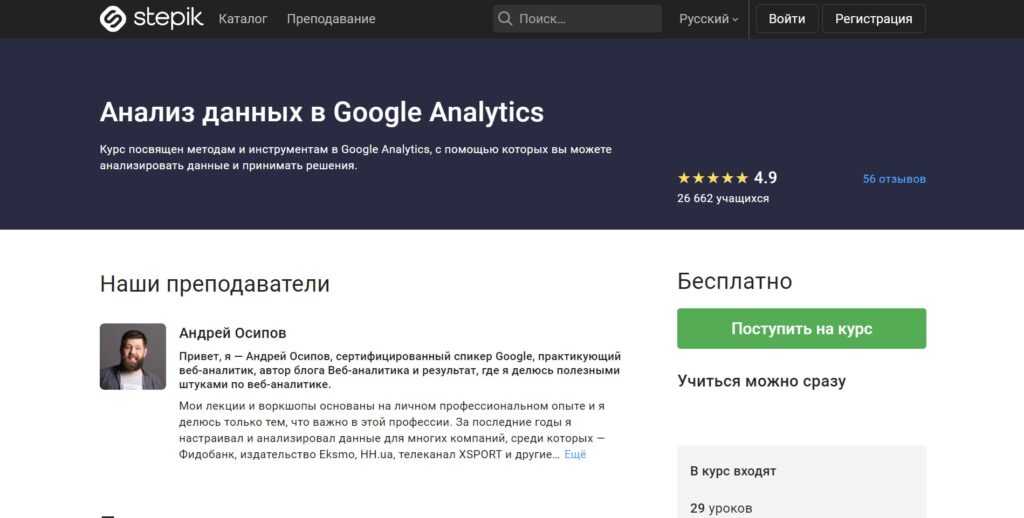

«Анализ данных в Google Analytics» от Андрея Осипова

Длительность: 29 уроков.

Формат обучения: видеоуроки + тесты.

Программа обучения: материал посвящён основным инструментам для анализа данных и принятия решений в Google Analytics. Курс подойдёт всем желающим освоить Google Analytics, а также тем, кто хочет повысить эффективность бизнеса без привлечения специалистов.

Чему научитесь:

- Работа с таблицами и сегментами

- Определение KPI

- Анализ электронной торговли

- Подготовка кастомных отчётов

- Выгрузка данных

- Работа в Google Data Studio

- Гибкий график обучения в свободное время

- Тесты для закрепления пройденного материала

- Можно сдать итоговый экзамен

- Лектор имеет большой опыт в веб-аналитике

«Базовые навыки Excel» от SF Education

Длительность: 29 уроков + 18 тестов.

Формат обучения: видеоуроки + тесты.

Программа обучения: курс посвящён основам работы в программе Excel. Он будет полезен менеджерам, предпринимателям, начинающим программистам, бухгалтерам и финансистам. Курс поможет ускорить выполнение рутинных задач, связанных с отчётами и аналитикой.

Какие навыки получите:

- Создание и сохранение таблиц

- Ввод данных и выполнение базовых расчётов

- Работа с ячейками, шрифтами и границами

- Заливка и форматирование ячеек

- Печать файлов и данных

- Сортировка, поиск и выделение данных

- Прохождение курса в удобное время

- Последовательная подача материала

- Современная программа обучения

- Отличный лектор

Преимущества и недостатки профессии

Любая профессия обладает не только преимуществами, но и определенными недостатками, которые необходимо принимать в расчет при выборе направления своей профессиональной деятельности.

Среди плюсов необходимо выделить:

- Востребованность на рынке труда.

- Высокий уровень оплаты труда.

- Возможность удаленной работы и фриланса.

- Престижность занимаемой профессии.

- Отличный вариант для любителей математики.

Среди недостатков необходимо указать:

- Сидячий образ жизни.

- Негативное воздействие на зрение и состояние спины.

- Характерное профессиональное выгорание за счет монотонности работы.

Что такое большие данные

Эта гигантские объемы информации, которые можно собрать и проанализировать только автоматизированным способом.

Предположим, каждый вечер после работы вы играете с собакой. Однажды вы заметили, что пес неприлично громко лает, бегая за мячом. При этом за резиновой игрушкой он гонится с такой же радостью, но молча. Несколько дней вы тестируете гипотезу: проверяете, действительно ли такую реакцию вызывает только мяч? Возможно, ведете дневник наблюдения, отмечая уровень шума по всем игрушкам. Убедившись в своей правоте, вы решаете играть с собакой в мяч только днем или в выходные. Отношения с соседями спасены.

Эти данные — «маленькие», их легко собрать и посчитать вручную, даже в уме. Большие данные — это терабайты разрозненной информации, которую надо собрать по кусочкам, обработать и перевести на «человеческий язык». Например, компания по производству игрушек для животных может анализировать привычки сотен тысяч собак, чтобы выпустить для них новый идеальный продукт.

Когда они сказали, что Excel-файл — это большие данные. Источник

Профессиональные направления в мире Big Data

Под термином «большие данные» скрывается множество понятий: от непосредственно самих информационных массивов до технологий по их сбору, обработке, анализу и хранению. Поэтому, прежде чем пытаться объять необъятное в стремлении изучить все, что относится к Big Data, выделим в этой области знаний следующие направления:

- инженерия – создание, настройка и поддержка программно-аппаратной инфраструктуры для систем сбора, обработки, аналитики и хранения информационных потоков и массивов, включая конфигурирование локальных и облачных кластеров. За эти процессы отвечают администратор и инженер Big Data. Чем отличается работа администратора больших данных от деятельности сисадмина, мы писали в этом материале. Какие именно навыки, знания и умения нужны специалистам по инженерии больших данных, а также сколько они за это получают, мы описываем в отдельных материалах.

На стыке вышеуказанных 2-х направлений находятся программист Big Data и DevOps-инженер, а также специалист по сопровождению жизненного цикла корпоративных данных (DataOps) и директор по данным (CDO, Chief Data Officer), который курирует на предприятии все вопросы, связанные с информацией. О роли каждого профессионала в Agile-команде мы немного рассказывали здесь.

Профессиональные направления и специальности Big Data

Полезные ссылки

- бесплатные курсы: Основы статистики;

- тренажеры: SQL;

- полезные материалы по продуктовой аналитике от команды МатеМаркетинга;

- чат с вакансиями в сфере анализа данных;

- канал с полезными материалами про работу с данными.

Артем Боровой: На мой взгляд, самый удобный путь — начать применять инструменты аналитика в своей текущей работе. Можно постепенно изучать языки и программы, а потом использовать их для своих задач. Конечно, не у всех может быть доступ к данным по месту работы, но для таких случаев есть площадки для самостоятельного обучения. Онлайн-курсы в этом плане проще и удобнее, так как человеку не нужно самому отбирать информацию, они помогают пройти по всем важным пунктам, дают материал в нужном темпе, погружают в комьюнити.

Рынок труда и будущее аналитики данных

Только за последние два года через направление Data Science Нетологии прошло более 3000 студентов, большинство из них работают на профильных позициях в российских и зарубежных компаниях.

Со временем эксперты ожидают повышение спроса на аналитиков Big Data и представителей смежных специальностей. Чтобы оставаться востребованными, необходимо учиться и работать.

По данным International Data Corp. (IDC), мировой доход от решений для больших данных и бизнес-аналитики (BDA) достигнет 260 миллиардов долларов в 2022 году при среднегодовом темпе роста (CAGR) 11,9 процента. В 2025 программные роботы будут выполнять большинство задач, таких как очистка и сбор данных, т.е. многие процессы станут более автоматизированными. К 2030 году Data Science уже не будет заниматься поиском и очисткой данных. Эту задачу возьмут на себя программные роботы.

В настоящее время технологии уже развиваются и достигают своих высот. Подумайте о будущем, когда искусственный интеллект будет в зените, машинное обучение — на пике, облако захватит рынок, а интернет вещей начнет проникать в большинство отраслей. Специалисту по данным потребуются лучшие навыки, будь то технические или социальные, чтобы быть востребованным к 2030 году.

По теме: Как проходит собеседование на должность аналитика данных в Facebook

Игорь Полянский, Head of Global product analytics в Gett:

«Мир продолжает ускоряться, а вместе с ним — и требования бизнеса к скорости принятия решений. Подход «задай вопрос, направь его аналитику, а он проанализирует» больше не удовлетворяет требования к оперативности получения инсайтов. Поэтому стандартные подходы к анализу все больше упаковываются в коробочные решения.

В 2020 году анализ, на который раньше уходили часы аналитика, менеджер может сделать в несколько кликов. Аналитики же делают более сложные исследования, и требования к их компетенциям повышаются. Системы аналитики все больше переходят на формат real-time анализа. У многих компаний это давно must have».

Составление грамотного резюме аналитика

Если почитать разнообразные образцы резюме аналитика в банк или другие организации, то новичкам и даже опытным соискателям кажется, что составить документ весьма просто.

Недооценка происходит, скорее всего, из-за малого объема бланка, нескольких разделов по 3-5 пунктов, однако сложность как раз в том, что сюда надо втиснуть максимум информации.

Получается некая «ловушка», особенно для опытных работников: у них есть что рассказать о своих успехах, однако объемные документы (по несколько страниц) эйчары даже не просматривают.

Соискателям при составлении резюме надо выявить ключевые слова для данной вакансии, так как продвинутые рекрутеры используют компьютерные алгоритмы

Вначале все резюме просматривает «умная» программа, отбирает документы, соответствующие запросам, и уже с отобранными резюме продолжает работу хедхантер.

То есть самый умелый аналитик может «пролететь» мимо вакансии, если в резюме не укажет ключевые навыки.

К счастью для новичков или асов аналитики, сами рекрутеры дают советы по составлению грамотного резюме аналитика данных, а задача соискателя – следовать им, заполняя документ правильно.

Базовые знания и навыки в Big Data

— Каждый специалист занят своим делом и решает определённый круг задач. Поэтому в начале карьеры стоит подумать, к каким задачам больше лежит душа. Что необходимо учить для старта в каждом направлении и как продвигаться по карьерной лестнице?

Нет необходимости делать выбор специальности в самом начале. Специалисты каждого направления имеют общую базу, с которой и нужно начинать обучение. Зная только общую базу, уже можно выполнять множество задач и быть частью Big Data. Углубляться в определённое направление я советую только после знакомства изнутри с тем, как выглядят проекты. Поэтому для совсем новичков я бы посоветовал «копать вширь», т.е. изучать инструменты, которые пригодятся в любой задаче Big Data.

— Из каких знаний/навыков состоит база Big Data?

Основа всего – это SQL. Да, именно SQL, а не общепринятые ООП, структуры данных, алгоритмы или Python. Это, наверное, сильно отличает Big Data от других направлений разработки, где для начала необходимо знать на приличном уровне какой-то из объектно-ориентированных языков.

В больших данных очень много задач, начиная с простейшего уровня и заканчивая важнейшими исследованиями для принятия бизнес-решений, решаются с помощью запросов к какой-либо базе данных

Причём совсем не важно, какая именно это будет БД. Возможно, это будет NoSQL база данных или даже не база данных вовсе, а простой набор файлов, лежащих в файловой системе

Demo day курса «Computer Vision»

4 августа в 20:00, Онлайн, Беcплатно

tproger.ru

События и курсы на tproger.ru

В любом из этих случаев нам очень пригодится понимание того, как можно обращаться к табличным данным, как читать по строкам и по колонкам, как соединять и фильтровать таблицы, какие ограничения существуют, как организовываются данные, какие данные можно получить из метаданных и т.д.

— На каком уровне нужно владеть SQL?

SQL мало просто знать. Обязательным является именно уверенное владением этим инструментом. Вплоть до Senior позиций любого направления одним из самых существенных показателем зарплаты является знание SQL. Поэтому эту технологию никогда не помешает узнать получше.

От новичка ожидают, что он сможет понять устройство данных в таблицах, не потратив на это весь день. Например, появляются ли дубли при запросе, сходятся ли идентификаторы в двух таблицах, наблюдаются ли потери данных, имеется ли достаточно данных в справочниках.

Перечислю, что ожидается по SQL от любого специалиста начального уровня:

- Идеальное знание join. Например, нужно найти записи, id которые есть только в таблице А или только в таблице B.

- Идеальное знание агрегирующий функций.

- Знание primary key и foreign key.

- Знание оконных функций.

- Поверхностное знание процедурного языка, например, PL SQL.

- Понимание того, что такое trigger, procedure, hint.

- Поверхностное знание нагрузки на базу данных. Например, нужно рассказать, чем отличается delete от truncate.

На собеседованиях необходимо будет решать задания вроде таких:

- Найти данные за максимальную дату.

- Выбрать учеников, у которые средняя оценка больше 3.

- Выбрать учеников, у которых больше двух оценок.

- Найти самые актуальные зарплаты сотрудников из истории повышений зарплат.

- Удалить дубли из таблицы.

— Какие ещё базовые навыки требуются, кроме владения SQL?

Кроме SQL от любого специалиста также ожидаются минимальные навыки работы с UNIX-системами. Доступ ко многим базам данных может осуществляться именно через UNIX-серверы, поэтому необходимы базовые навыки работы с таким окружением. Достаточно будет знать команды ls, cat, mkdir, rm, touch, grep, awk, sed, а также знать, что такое stdin, stdout, stderr.

Во многих компаниях не станут спрашивать, что такое структуры данных, сложность алгоритмов (хотя иногда могут спросить ради оценки общей IT-эрудиции). Не нужно будет решать алгоритмы и применять паттерны проектирования ООП. Скорее всего, не придётся рассказывать про устройство и архитектурные особенности базы данных, на которую вас зовут работать.

Обычно с оптимизациями всегда помогают более опытные сотрудники. От новичков не требуется писать архитектурно верные запросы. Как видите, набор базовых навыков совсем небольшой, а, значит, нет необходимости долго готовиться к первым собеседованиям. Несколько месяцев подготовки вполне может быть достаточно.

Где получить знания в области обработки данных

Вузы

К сожалению, пока что в вузах очень мало обучают анализу данных. Есть несколько исключений:

- Факультет компьютерных наук в Высшей Школе Экономики

- Факультет инноваций и высоких технологий в МФТИ

- Магистерская программа «Большие Данные» на факультете ВМиК МГУ

- Магистерская программа по большим данным в СПБГУ

Конечно, и в других учебных программах также освещаются те или иные аспекты работы с данными. Но вузовские программы, которые готовят специалистов комплексно, на этом фактически исчерпываются. Неудивительно: отрасль совершенно новая, специалистов и преподавателей нет. Вузы, где все-таки вводятся программы по обработке данных, обычно делают это в сотрудничестве с крупными компаниями (например, «Яндексом»).

Некоммерческие курсы дополнительного образования

Так как на рынке наблюдается острый дефицит кадров – некоторые компании создают собственные учебные центры. Здесь может учиться любой желающий – нужно только сдать экзамены.

В этой категории можно смотреть на следующие курсы:

- Школа Анализа Данных «Яндекса» – самый старый и самый известный центр подготовки кадров в области анализа данных. Занятия ведут сотрудники «Яндекса», а также преподаватели лучших вузов страны. Программа рассчитана на 2 года.

- Техносфера Mail.Ru и факультета ВМиК МГУ – во многом аналогичная программа от второго интернет-гиганта, Mail.Ru. Также рассчитаная на 2 года.

- Технопарк Mail.Ru и МГТУ им. Баумана – в отличие от «Техносферы», эти курсы больше рассчитаны на подготовку системных инженеров, однако курсу по анализу данных там тоже нашлось место. Срок обучения – 2 года.

- Центр компьютерных наук – совместный проект Школы Анализа Данных «Яндекса», компании Jet Brains и школы №239 в Санкт-Петербурге. Срок обучения – также 2 года.

- Петербургская школа данных– цикл лекций, посвященный большим данным, в Петербурге. Проект компании E-Contenta.

Коммерческие курсы

Есть несколько коммерческих программ, позволяющих расширить свой кругозор в области анализа данных. Их отличительные черты – короткий срок обучения и большая направленность на прикладное применение технологий.

Тут можно вспомнить следующие проекты:

- Курс Специалист по большим данным» от «Лаборатории Новых Профессий». Длится 3 месяца, состоит из 2 модулей, первый из которых посвящен технологиям больших данных и машинному обучению, а второй –рекомендательным системам. Стоимость курса – 180 тысяч рублей, предусмотрены различные скидки и рассрочки.

- Школа данных Билайна» – курс, в первую очередь, посвящен Machine Learning Продолжительность обучения – 9 недель, стоимость – 100 тысяч рублей.

Онлайн-образование

В последнее время отрасль онлайн-образования переживает настоящий бум, и на ресурсах вроде Coursera, Edx, Stepic и Udacity можно найти огромное число курсов по обработке данных. Большинство – англоязычные (кстати, знание английского языка очень полезно в нашей области), но есть и несколько русскоязычных:

- Специализация «Машинное обучение и анализ данных» на Coursera;

- «Введение в машинное обучение» на Coursera;

- «Анализ данных в R» на Stepic.

Личные навыки в резюме аналитика

«Прокачанные» навыки полезны не только в компьютерных играх, каждый специалист ценится из-за приобретенных умений, полезных, конечно же, работодателю.

Резюме бизнес-аналитика однозначно должно включать аналитические умения, причем их надо еще и правильно оформить.

Перед заполнением этой графы или прямо в процессе работы надо подумать, какие навыки лучше подойдут к данной вакансии, так как перечисление всех умений аналитика только ухудшит ситуацию.

Даже если рекрутер поверит в наличие десятков умений, он просто не будет вчитываться в длиннющий список, поэтому в данном подразделе надо ограничиться 5-6 позициями.

В целом рекрутеры хотят видеть у аналитиков такие навыки:

- Аналитические. Умение работать с большими объемами всевозможных данных.

- Математические. Пояснять особо нечего.

- Коммуникативные. Крайне полезное и достаточно редкое умение, когда человек не просто делает выводы, а способен их доступно объяснить непрофессионалам.

- Технические. Владение программами, языками программирования, методами визуализации и пр.

- Креативные. Использование новых подходов к решению проблем.

В резюме экономиста-аналитика, например, более важны экономические навыки, чем технические, но все прочие должны наличествовать.

Даже если на вакансию откликается молодой специалист без опыта, он должен описать личные умения, перечислив все программы, которыми владеет и которыми пользовался при разработке хотя бы курсовых проектов или дипломных работ.

Как стать Data Engineer и куда расти

Профессия дата-инженера довольно требовательна к бэкграунду. Костяк профессии составляют разработчики на Python и Scala, которые решили уйти в Big Data. В русскоговорящих странах, к примеру, процент использования этих языков в работе с большими данными примерно 50/50. Если знаете Java — тоже хорошо.

Хорошее знание SQL тоже важно. Поэтому в Data Engineer часто попадают специалисты, которые уже ранее работали с данными: Data Analyst, Business Analyst, Data Scientist

Дата-сайентисту с опытом от 1–2 лет будет проще всего войти в специальность.

Фреймворками можно овладевать в процессе работы, но хотя бы несколько важно знать на хорошем уровне уже в самом начале. Дальнейшее развитие для специалистов Big Data Engineers тоже довольно разнообразное

Можно уйти в смежные Data Science или Data Analytics, в архитектуру данных, Devops-специальности. Можно также уйти в чистую разработку на Python или Scala, но так делает довольно малый процент спецов

Дальнейшее развитие для специалистов Big Data Engineers тоже довольно разнообразное. Можно уйти в смежные Data Science или Data Analytics, в архитектуру данных, Devops-специальности. Можно также уйти в чистую разработку на Python или Scala, но так делает довольно малый процент спецов.

Перспективы у профессии просто колоссальные. Согласно данным Dice Tech Job Report 2020, Data Engineering показывает невероятные темпы роста — в 2019 году рынок профессии увеличился на 50 %. Для сравнения: стандартным ростом считается 3–5 %.

В 2020 году темпы замедлились, но всё равно они многократно опережают другие отрасли. Спрос на специальность вырос ещё на 24,8 %. И подобные темпы сохранятся еще на протяжении минимум пяти лет.

Так что сейчас как раз просто шикарный момент, чтобы войти в профессию Data Engineering с нашим курсом Data Engineering и стать востребованным специалистом в любом серьёзном Data Science проекте. Пока рынок растёт настолько быстро, то возможность найти хорошую работу, есть даже у новичков.

Узнайте, как прокачаться и в других областях работы с данными или освоить их с нуля:

Что должен знать Data Engineer

-

Структуры и алгоритмы данных;

-

Особенности хранения информации в SQL и NoSQL базах данных. Наиболее распространённые: MySQL, PostgreSQL, MongoDB, Oracle, HP Vertica, Amazon Redshift;

-

ETL-системы (BM WebSphere DataStage; Informatica PowerCenter; Oracle Data Integrator; SAP Data Services; SAS Data Integration Server);

-

Облачные сервисы для больших данных Amazon Web Services, Google Cloud Platform, Microsoft Azure;

-

Кластеры больших данных на базе Apache и SQL-движки для анализа данных;

-

Желательно знать языки программирования (Python, Scala, Java).

Стек умений и навыков инженера больших данных частично пересекается с дата-сайентистом, но в проектах они, скорее, дополняют друг друга.

Data Engineer сильнее в программировании, чем дата-сайентист. А тот, в свою очередь, сильнее в статистике. Сайентист способен разработать модель-прототип обработки данных, а инженер — качественно воплотить её в реальность и превратить код в продукт, который затем будет решать конкретные задачи.

Инженеру не нужны знания в Business Intelligence, а вот опыт разработки программного обеспечения и администрирования кластеров придётся как раз кстати.

Но, несмотря на то что Data Engineer и Data Scientist должны работать в команде, у них бывают конфликты. Ведь сайентист — это по сути потребитель данных, которые предоставляет инженер. И грамотно налаженная коммуникация между ними — залог успешности проекта в целом.

Плюсы и минусы профессии инженера больших данных

Плюсы:

-

Отрасль в целом и специальность в частности ещё очень молоды. Особенно в России и странах СНГ. Востребованность специалистов по BDE стабильно растёт, появляется всё больше проектов, для которых нужен именно инженер больших данных. На hh.ru, по состоянию на начало апреля, имеется 768 вакансий.

-

Пока что конкуренция на позиции Big Data Engineer в разы ниже, чем у Data Scientist. Для специалистов с опытом в разработке сейчас наиболее благоприятное время, чтобы перейти в специальность. Для изучения профессии с нуля или почти с нуля — тоже вполне хорошо (при должном старании). Тенденция роста рынка в целом будет продолжаться ближайшие несколько лет, и всё это время будет дефицит хороших спецов.

-

Задачи довольно разнообразные — рутина здесь есть, но её довольно немного. В большинстве случаев придётся проявлять изобретательность и применять творческий подход. Любителям экспериментировать тут настоящее раздолье.

Минусы

-

Большое многообразие инструментов и фреймворков. Действительно очень большое — и при подготовке к выполнению задачи приходится серьёзно анализировать преимущества и недостатки в каждом конкретном случае. А для этого нужно довольно глубоко знать возможности каждого из них. Да-да, именно каждого, а не одного или нескольких.

Уже сейчас есть целых шесть платформ, которые распространены в большинстве проектов.

Spark — популярный инструмент с богатой экосистемой и либами, для распределенных вычислений, который может использоваться для пакетных и потоковых приложений. Flink — альтернатива Spark с унифицированным подходом к потоковым/пакетным вычислениям, получила широкую известность в сообществе разработчиков данных. Kafka — сейчас уже полноценная потоковая платформа, способная выполнять аналитику в реальном времени и обрабатывать данные с высокой пропускной способностью. ElasticSearch — распределенный поисковый движок, построенный на основе Apache Lucene. PostgreSQL — популярная бд с открытым исходным кодом. Redshift — аналитическое решение для баз/хранилищ данных от AWS.

-

Без бэкграунда в разработке ворваться в BD Engineering сложно. Подобные кейсы есть, но основу профессии составляют спецы с опытом разработки от 1–2 лет. Да и уверенное владение Python или Scala уже на старте — это мастхэв.

-

Работа такого инженера во многом невидима. Его решения лежат в основе работы других специалистов, но при этом не направлены прямо на потребителя. Их потребитель — это Data Scientist и Data Analyst, из-за чего бывает, что инженера недооценивают. А уж изменить реальное и объективное влияние на конечный продукт и вовсе практически невозможно. Но это вполне компенсируется высокой зарплатой.

Аналитик проекта

Одна из важнейших составляющих в проекте больших данных – аналитика. От работы аналитиков зависит конечный результат. Можно собрать идеальные громадные массивы красиво структурированных данных и поместить их на великолепный суперсервер, но, если аналитик ничего не скажет полезного для бизнеса после того, как замучает хранилище запросами, – проект провалится. Аналитик в какой-то степени защищен от неудачи, если изначально разработана качественная модель потоков больших данных с выходными параметрами и показателями. Но от уровня профессионализма аналитика зависит очень многое, особенно – когда на строгий суд заказчика понадобится представить хоть что-нибудь впечатляющее и объяснить, куда потрачены дефицитные финансовые ресурсы.

По теме: Что такое демонстрация проекта и зачем она вам нужна?

Аналитики проекта больших данных должны обладать профессиональными знаниями и умениями в области сбора и обработки данных, в области анализа экономических, финансовых, статистических и производственных данных. Фактически вся ключевая смысловая работа с данными ложиться на аналитиков проекта.

Выделим несколько специализаций:

- Аналитик бизнес-модели. Зона ответственности: понимание бизнес-модели, анализ бизнес-модели на основе традиционных и больших данных, формулировка и обоснование изменений в бизнес-модель, подготовка решений по бизнес-модели, увязка бизнес-модели и больших данных, требования к данным;

- Аналитик структур данных. Зона ответственности: понимание структур данных и их связь с элементами бизнес-модели, контроль и корректировка смысловой целостности данных и метаданных, изменение структур и классификации данных, контроль качества данных, сервис данных;

- Аналитик рисков. Зона ответственности: оценка потенциальных угроз данным и контроль информационных рисков, контроль достоверности данных и их источников, контроль рисков принятия решений на основе больших данных, вероятностная оценка прогнозных моделей.

Аналитик – это уникальный специалист для каждого конкретного бизнеса. Он обладает исключительными компетенциями для понимания бизнес-модели. Уровень информации, к которой он имеет доступ – это фактически уровень топ-менеджмента соответствующего направления. По доступу к информации, осведомленности и пониманию особенностей бизнеса он ближе к руководству, чем к экспертной категории сотрудников. А иногда аналитик объективней и реалистичней, чем само руководство. От результатов его работы зависит общее понимание экономической, финансовой, производственной, маркетинговой ситуации, в которой оказался бизнес сегодня. Аналитик знает, что к этому привело и как бизнес поведет себя в будущем.

Опыт работы профессионального аналитика весьма ценен для любого бизнеса. Он уникален так же, как уникальна каждая отстроенная бизнес-модель.

Не следует путать аналитика со статистиком или математиком. Он обычно понимает и умеет формулировать математические модели определенного класса, умеет применять статистические инструменты для обработки данных. В большей же степени он должен разбираться в том, как данные увязаны с бизнес-процессами и бизнес-объектами. Аналитику необходимо уметь разбираться в том, что означают собранные и обработанные данные с точки зрения экономических, производственных и рыночных процессов. Математические исследования и статистические доказательства – это не зона ответственности аналитика, это его инструментарий.

Аналитик – это и эксперт, и исследователь, и исполнитель, и дизайнер данных. Но аналитик не в состоянии заменить, например, «классного» менеджера по продажам. Это значит, что никакой глубокий, традиционный или большой анализ данных не наладит производственный или логистический процесс, не улучшит привлекательность и качество продукта, не гарантирует устойчивое финансовое положение

Аналитика лишь в состоянии показать, что идет не так в бизнесе, что заменить в бизнес-модели, на что обратить внимание

Образец резюме аналитика

Пример резюме аналитика можно отыскать в Сети, хотя их намного меньше, чем документов с резюме бухгалтеров или экономистов.

Можно скачать образец из проверенного источника, чтобы оставить форматирование бланка, шрифты и т. п., но информацию лучше полностью стирать, заполняя графы самостоятельно.

Ожидаемая должность:

Цель: получение должности системного аналитика, зарплата – от 80 000 р.

Образование:

Уральский федеральный университет, специальность «Прикладная математика», 2000-2006 гг.

Языки: английский – advanced.

Курсы: язык «R» – 2012 г.

Опыт работы:

Страховая компания «Максимум доверия», системный аналитик, с 2009 г. по настоящее время.

Достижения на работе:

- администрирование сетевого оборудования Cisco;

- администрирование Workstation;

- постройка моделей статистического анализа Big Data с использованием Teradata;

- уменьшение благодаря проведенному анализу количества страховых случаев на 7 %.

Профессиональные навыки и умения:

- использование языка R для визуализации данных;

- умение программировать при помощи XML, JavaScript frameworks, ETL;

- эксперт в работе с Excel, SAS, Minitab;

- умение понятно интерпретировать данные для ознакомления;

- многолетний опыт использования Oracle и MS Access.

Написать правильное резюме аналитика – достаточно нетривиальная задача, учитывая множество требований работодателей, но награда в виде высокой зарплаты и прочих льгот стоит того, чтобы досконально разобраться в вопросе и составить лучшее резюме.

![35 бесплатных курсов по data science и аналитике big data [2021] для начинающих с нуля](http://tehnikaarenda.ru/wp-content/uploads/2/f/2/2f2bb11d6c884fda6b45abe2631a5eec.jpeg)