Backup виртуальных машин

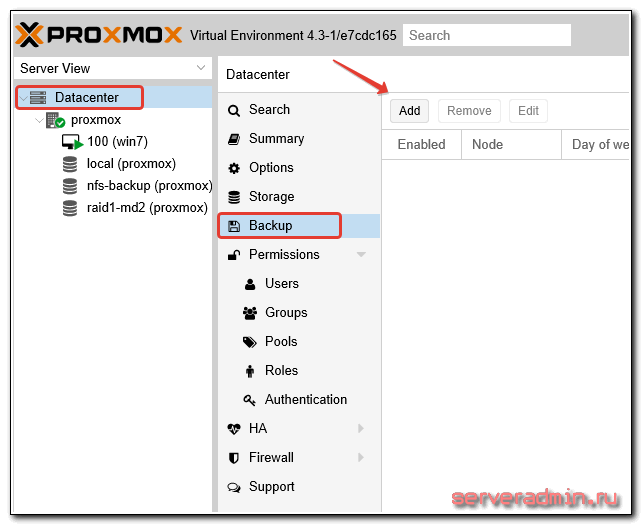

Подошли к очень важному этапу настройки proxmox — огранизация бэкапа виртуальных машин. На этот момент нужно обратить особенное внимание, и все хорошенько проверить. Настраивается backup так же просто, как и все остальное в proxmox. Идем в раздел Backup и создаем задание:

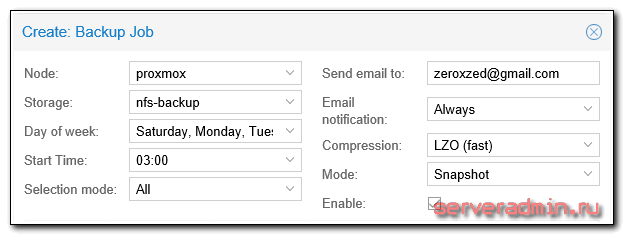

Выставляем небоходимые параметры, например такие:

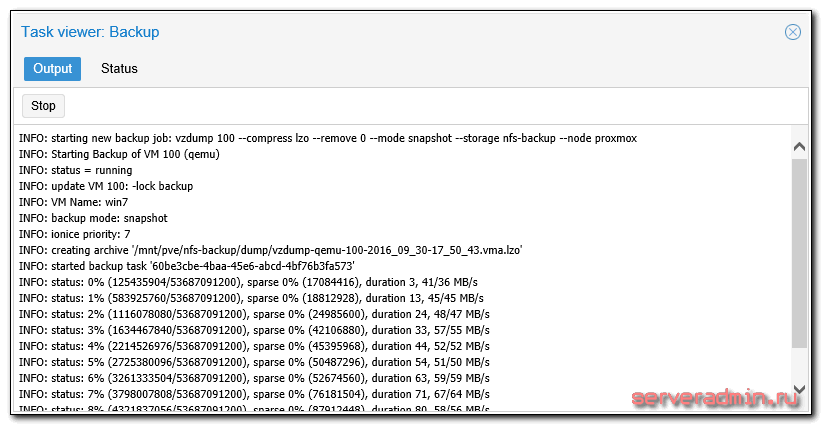

Ждем назначенного часа и проверяем исполнение задания.

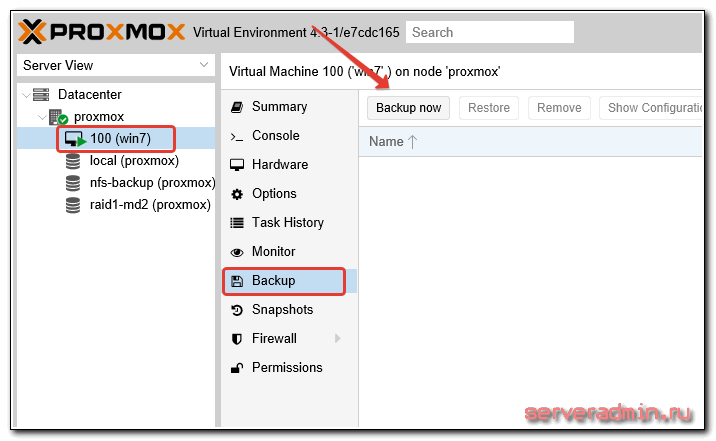

Для того, чтобы выполнить разовый бэкап конкретной виртуальной машины, достаточно открыть виртуальную машины, выбрать в ней раздел Backup и нажать Backup Now:

Дальше указываете необходимые параметры и дожидаетесь завершения бэкапа

Обращаю внимание, что бэкап будет выполняться при работающей виртуальной машине. Останавливаеть ее не требуется.

Тут сразу встает следующий вопрос — как автоматически удалять старые бэкапы? Однозначно ответить не получится, все будет зависеть от того, где будут храниться бэкапы. Если это обычный linux сервер с доступом к консоли, то можно воспользоваться программой find:

Идем в раздел Backup и создаем задание:

Выставляем небоходимые параметры, например такие:

Ждем назначенного часа и проверяем исполнение задания.

Для того, чтобы выполнить разовый бэкап конкретной виртуальной машины, достаточно открыть виртуальную машины, выбрать в ней раздел Backup и нажать Backup Now:

Дальше указываете необходимые параметры и дожидаетесь завершения бэкапа. Обращаю внимание, что бэкап будет выполняться при работающей виртуальной машине. Останавливаеть ее не требуется.

Тут сразу встает следующий вопрос — как автоматически удалять старые бэкапы? Однозначно ответить не получится, все будет зависеть от того, где будут храниться бэкапы. Если это обычный linux сервер с доступом к консоли, то можно воспользоваться программой find:

# /usr/bin/find /mnt/backups-vm -type f -mtime +30 -exec rm {} \;

После выполнения этой команды, все файлы в папке /mnt/backups-vm старше 30 дней будут удалены. Для автоматизации процесса команду можно поместить в cron. С помощью zabbix вы можете мониторить актуальность бэкапов и следить за их размерами.

После создания бэкапа рекомендую сразу убедиться, что из него можно восстановить виртуальную машину. Для этого откройте обзор сторейджа, где у вас сделана копия и оттуда начните процесс восстановления. В таком случае вы сможете указать новое имя для виртуальной машины. Если вы будете пробовать восстановить из бэкапа в интерфейсе виртуальной машины, то будет предложена только замена существующей ВМ.

Установка proxmox на debian

За основу взята статья из официальной wiki Install Proxmox VE on Debian Wheezy

Предполагается, что читатель знаком с процессом установки Debian, знает основы mdraid, LVM, и процедуру подготовки дисков.

Предпосылки:

Собственно, она одна: при установке proxmox с дистрибутива нет возможности вручную разбить диски, как следствие нельзя установить proxmox на софтварный RAID.

Как разбиваем диски:

Раздел “/boot” ставим отдельно на raid-1, раздел “/” ставим отдельно на любой raid, и еще предусматриваем раздел для данных это тоже будет raid (в идеале 10, можно 1, но ни в коем случае не рекомендую 5), поверх него ставим LVM (надо для проксмокс что бы тот мог делать снапшоты).

Итак, при установке делаем на каждом диске следующие разделы:

swap (общий объем = ОЗУ) md0 (делаем RAID1 ) “/boot” (общий размер 500Мб) md1 (RAID1 или RAID10 или RAID5) “/” (общий объем 50Гб) md2 (RAID1 или RAID10) это будет физический том для LVM

Установка:

Ставим debian при этом разбиваем диски как указано выше.

Подготовка раздела для данных proxmox (в команде после ключа вставить размер ):

aptitude install lvm2 pvcreate /dev/md2 vgcreate pve /dev/md2 vgdisplay | grep "Total PE" lvcreate -l <Total PE> --name data pve mkfs -t ext3 /dev/pve/data mkdir /var/lib/vz mount /dev/mapper/pve-data /var/lib/vz

Добавляем строку в

# pve-data /dev/mapper/pve-data /var/lib/vz ext3 noatime 0 0

Сеть должна быть со статическим IP, по этому в

# The primary network interface allow-hotplug eth0 auto eth0 iface eth0 inet static address 192.168.100.20 netmask 255.255.255.0 gateway 192.168.100.1

А в (kn20 – имя нашего сервера)

Очень важно прописать наш хост в hosts! Если этого не сделать, то proxmox не сможет определить свое имя и не запустится.

В той версии proxmox которую я ставил (3.2-4) есть еще косяк – proxmox не поддерживает IPv6, и если в hosts есть строки с IPv6, то prxmox не может его распарсить и опять же не может определить собственное имя и по этому не запускается

192.168.100.20 kn20.caesber.local kn20

Добавляем в файл репозиторий:

# PVE pve-no-subscription repository provided by proxmox.com, NOT recommended for production use deb http://download.proxmox.com/debian wheezy pve-no-subscription

Устанавливаем ключи репозитория Proxmox и делаем апдейт его и системы

wget -O- "http://download.proxmox.com/debian/key.asc" | apt-key add - apt-get update && apt-get dist-upgrade

Устанавливаем ядро:

apt-get install pve-firmware pve-kernel-2.6.32-26-pve apt-get install pve-headers-2.6.32-26-pve

Перезагружаемся в это ядро, проверяем, удаляем старое ядро:

uname -a Linux kn20 2.6.32-26-pve... apt-get remove linux-image-amd64 linux-image-3.2.0-4-amd64 update-grub

Устанавливаем Proxmox VE

apt-get install proxmox-ve-2.6.32 ntp ssh lvm2 postfix ksm-control-daemon vzprocps open-iscsi bootlogd

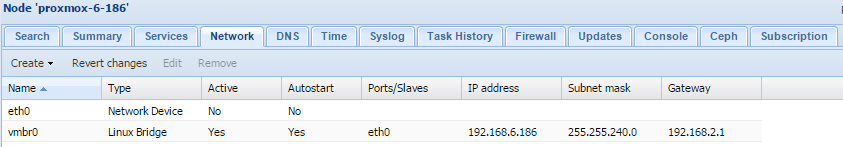

Заходим на web-морду (https://192.168.100.20:8006/) , настраиваем vmbr0 и перезагружаемся

(изображение ниже взято из wiki, по этому адреса другие, привел просто для примера как должно выглядеть и на какой вкладке настраивать)

ГОТОВО!

Backup виртуальных машин

Подошли к очень важному этапу настройки proxmox — огранизация бэкапа виртуальных машин. На этот момент нужно обратить особенное внимание, и все хорошенько проверить. Настраивается backup так же просто, как и все остальное в proxmox. Идем в раздел Backup и создаем задание:

Идем в раздел Backup и создаем задание:

Выставляем небоходимые параметры, например такие:

Ждем назначенного часа и проверяем исполнение задания.

Для того, чтобы выполнить разовый бэкап конкретной виртуальной машины, достаточно открыть виртуальную машины, выбрать в ней раздел Backup и нажать Backup Now:

Дальше указываете необходимые параметры и дожидаетесь завершения бэкапа

Обращаю внимание, что бэкап будет выполняться при работающей виртуальной машине. Останавливаеть ее не требуется

Тут сразу встает следующий вопрос — как автоматически удалять старые бэкапы? Однозначно ответить не получится, все будет зависеть от того, где будут храниться бэкапы. Если это обычный linux сервер с доступом к консоли, то можно воспользоваться программой find:

# /usr/bin/find /mnt/backups-vm -type f -mtime +30 -exec rm {} ;

После выполнения этой команды, все файлы в папке /mnt/backups-vm старше 30 дней будут удалены. Для автоматизации процесса команду можно поместить в cron. С помощью zabbix вы можете мониторить актуальность бэкапов и следить за их размерами.

После создания бэкапа рекомендую сразу убедиться, что из него можно восстановить виртуальную машину. Для этого откройте обзор сторейджа, где у вас сделана копия и оттуда начните процесс восстановления. В таком случае вы сможете указать новое имя для виртуальной машины. Если вы будете пробовать восстановить из бэкапа в интерфейсе виртуальной машины, то будет предложена только замена существующей ВМ.

Для 4 версии Proxmox

С инструкцией по подключению USB устройств вы можете ознакомится на официальном сайте Proxmox.

Определение устройства

Подключим в систему Proxmox необходимое устройство и в консоли выведем информацию о подключенияx.

lsusb = вывод команды = Bus 001 Device 005: ID 0781:5572 SanDisk Corp. Bus 001 Device 001: ID 1d6b:0002 Linux Foundation 2.0 root hub Bus 005 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub Bus 004 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub Bus 003 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub Bus 002 Device 003: ID 0665:5161 Cypress Semiconductor USB to Serial Bus 002 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub

Видим подключенную флэшку.

Выведем информации о том на каких портах висят устройства.

lsusb -t = вывод команды = /: Bus 05.Port 1: Dev 1, Class=root_hub, Driver=uhci_hcd/2p, 12M /: Bus 04.Port 1: Dev 1, Class=root_hub, Driver=uhci_hcd/2p, 12M /: Bus 03.Port 1: Dev 1, Class=root_hub, Driver=uhci_hcd/2p, 12M /: Bus 02.Port 1: Dev 1, Class=root_hub, Driver=uhci_hcd/2p, 12M |__ Port 1: Dev 3, If 0, Class=Human Interface Device, Driver=usbfs, 1.5M /: Bus 01.Port 1: Dev 1, Class=root_hub, Driver=ehci-pci/8p, 480M |__ Port 3: Dev 5, If 0, Class=Mass Storage, Driver=usb-storage, 480M

Видим нашу флэшку которая села на Bus 01—Dev 5 наPort 3.

Варианты проброса устройств

Существуют два вариант передачи USB-устройства в виртуальную (гостевую) систему:

- передать определенное устройство — при перемещении usb-устройства в другой порт не надо ничего перенастраивать. Вариант хорош, когда надо пробросить одно устройство и второго подобного не будет,

- передать порт — вариант передает порт на котором работает устройство.

Оба варианта имеют свои нюансы и решать каким пользоваться только вам. Мне больше нравится вариант с пробросим порта, так как он не вызывает непонятных проблем после перезагрузки.

Проброс осуществляются по номеру виртуальной машины. Папка с файлами для редактирования находится по адресу /etc/pve/qemu-server/ в ней вы увидите все ваши виртуальные машины.

Проброс USB устройства

Откроем необходимый файл и добавим нужные параметры.

mcedit /etc/pve/qemu-server/104.conf = вывод команды с необходимыми добавлениями = balloon: 500 bootdisk: sata0 cores: 2 ide2: local:iso/CentOS-7-x86_64-DVD-1511.iso,media=cdrom memory: 1500 name: lamp.sevo44.ad-centos7 net0: e1000=7A:5A:34:67:6C:52,bridge=vmbr0 numa: 0 onboot: 1 ostype: l26 sata0: images:104/vm-104-disk-1.qcow2,size=400G scsihw: virtio-scsi-pci smbios1: uuid=4374a7e1-1fc7-4eaf-9567-aa5f9cb19b33 sockets: 2 # Проброс устройства USB # где 0781:5572 - это device ID usb0: host=0781:5572

Проброс USB порта

Для проброса по порту надо указать другую строчку в необходимом файле.

mcedit /etc/pve/qemu-server/104.conf = вывод команды с необходимыми добавлениями = balloon: 500 bootdisk: sata0 cores: 2 ide2: local:iso/CentOS-7-x86_64-DVD-1511.iso,media=cdrom memory: 1500 name: lamp.sevo44.ad-centos7 net0: e1000=7A:5A:34:67:6C:52,bridge=vmbr0 numa: 0 onboot: 1 ostype: l26 sata0: images:104/vm-104-disk-1.qcow2,size=400G scsihw: virtio-scsi-pci smbios1: uuid=4374a7e1-1fc7-4eaf-9567-aa5f9cb19b33 sockets: 2 # Проброс USB порта # где 1-3 это шина Bus 01 и номер порта Port 3 usb0: 1-3

После перезагрузки устройства будут проброшены.

Проверка аппаратной поддержки виртуализации

Проверка поддержки виртуализации в процессоре выполняется командой:

egrep '(vmx|svm)' /proc/cpuinfo =вывод команды= flags : fpu vme de pse tsc msr pae mce cx8 apic sep mtrr pge mca cmov pat pse36 clflush dts acpi mmx fxsr sse sse2 ss ht tm pbe syscall nx lm constant_tsc arch_perfmon pebs bts rep_good nopl aperfmperf pni dtes64 monitor ds_cpl vmx tm2 ssse3 cx16 xtpr pdcm dca lahf_lm tpr_shadow dtherm flags : fpu vme de pse tsc msr pae mce cx8 apic sep mtrr pge mca cmov pat pse36 clflush dts acpi mmx fxsr sse sse2 ss ht tm pbe syscall nx lm constant_tsc arch_perfmon pebs bts rep_good nopl aperfmperf pni dtes64 monitor ds_cpl vmx tm2 ssse3 cx16 xtpr pdcm dca lahf_lm tpr_shadow dtherm flags : fpu vme de pse tsc msr pae mce cx8 apic sep mtrr pge mca cmov pat pse36 clflush dts acpi mmx fxsr sse sse2 ss ht tm pbe syscall nx lm constant_tsc arch_perfmon pebs bts rep_good nopl aperfmperf pni dtes64 monitor ds_cpl vmx tm2 ssse3 cx16 xtpr pdcm dca lahf_lm tpr_shadow dtherm flags : fpu vme de pse tsc msr pae mce cx8 apic sep mtrr pge mca cmov pat pse36 clflush dts acpi mmx fxsr sse sse2 ss ht tm pbe syscall nx lm constant_tsc arch_perfmon pebs bts rep_good nopl aperfmperf pni dtes64 monitor ds_cpl vmx tm2 ssse3 cx16 xtpr pdcm dca lahf_lm tpr_shadow dtherm

Если в выводе присутствует параметр svm (Secure Virtual Machines) — значит процессор с поддержкой аппаратной виртуализации от AMD, если vmx (Virtual Machine eXtension) — значит процессор Intel.

Если вывод пустой, то смотрите в bios на предмет включения виртуализации, в противном случае использовать Proxmox не получится.

Настройка гипервизора Proxmox VE

Первым делом обновим наш Debian

~# apt-get update

~#apt-get full-upgrade

Затем, утилитой fdisk посмотрим состояние наших дисков и разделов.

~# fdisk -L

/dev/vda и /dev/vdb — ssd 120 Gb, на который установлен Proxmox.

/dev/vdc и /dev/vdd — ssd 500 Gb, на которых мы будем собирать программный raid с помощью утилиты mdadm.

Они пусты, нам необходимо создать партиции разделов. Ниже приведен пример, как это сделать для /dev/vdc, такую же процедуру необходимо выполнить для /dev/vdd, создав партиции /dev/vdc1 и /dev/vdd1 соответственно.

~# mdadm --create --verbose /dev/md0 --level=1 --raid-devices=2 /dev/vdc1 /dev/vdd1

Данная процедура может занять некоторое время, проверять состояние синхронизации вы можете командой:

~# cat /proc/mdstat

После успешной синхронизации программного raid массива, мы увидим следующую картину:

Следующим этапом, создадим файловую систему ext4 на программном рейде /dev/md127

~# mkfs.ext4 /dev/md127

Командой blkid проверим uuid собранного raid /dev/md127

В нашем случае, это:

/dev/md127: UUID=»400de0bd-6de7-46e5-a6ca-d03b11fe1c6f» TYPE=»ext4″

Создадим каталог data, который смонтируем к нашей новой fs

~# mkdir /mnt/data

~# mount /dev/md127 /mnt/data

Далее правим файл /cat/fstab, указывая новую точку монтирования, чтобы после перезагрузки гипервизора изменения остались в силе. У нас должен получиться следующий результат:

Как вы могли не заметить, установка программной части Proxmox VE у нас выполнена на файловой системе ZFS. Это масштабируемая FS, работа которой, и работа с которой в корне отличается от привычных нам ext4 и иже с ней. Эта файловая система разрабатывалась под UNIX, и для корректно работы с Linux потребуется некоторый тюннинг. Это обусловлено так же особенностью работы с оперативной памятью. Чтобы исключить неконтролируемое потребление ОЗУ, создадим следующий файл:

~# touch /etc/modprobe.d/zfs.conf

В который необходимо добавить следующие параметры:

options zfs zfs_arc_max=2147483648

options zfs zfs_arc_min=1073741824

options zfs zfs_prefetch_disable=1

Применим изменения:

~# update-initramfs -u

Настроим swappiness в Linux. Параметр vm.swappiness по умолчанию имеет значение 60, и контролирует процент свободной памяти. Он контролирует значение, после которого начнется активный сброс данных в swap. Значение «60» означает следующее: 100-60=40%. Другими словами, при загрузке ОЗУ более чем 40%, данные начнут кешироваться в swap. Не существует оптимального значения, он обусловлен только конфигурацией вашего сервера. Если ОЗУ достаточно, это значение можно уменьшить следующими командами:

~# echo 10 > /proc/sys/vm/swappiness

или

~# sysctl -w vm.swappiness=10

Чтобы после перезагрузки значения не сбросились до первоначальных, в файле /etc/sysctl.conf необходимо добавить: vm.swappiness=10

Применить настройку «на лету» можно следующей командой:

Чтобы после перезагрузки значения не сбросились до первоначальных, в файле /etc/sysctl.conf необходимо добавить: vm.swappiness=10

~# sysctl -p

Выше были рассмотрены базовые настройки для полноценного функционирования гипервизора. Оптимизация остальных параметров, таких как настройка программного обеспечения, настройка smart мониторинга ssd дисков и т. д., не отличается от работы с любым другим дистрибутивом Linux Debian.

Перенос загрузочных файлов на RAID[]

Подготовим загрузочный RAID-раздел второго диска и скопируем на него все файлы из папки /boot первого диска

mkfs.ext3 /dev/md0 mkdir /mnt/md0 mount /dev/md0 /mnt/md0 cp -ax /boot/* /mnt/md0 umount /mnt/md0 rmdir /mnt/md0

Настроим параметры подключения системных дисков с учетом загрузки с raid. Пересоздадим конфигурационный файл fstab предварительно сохранив оригинальный.

cp /etc/fstab /etc/fstab.orig echo "" > /etc/fstab nano /etc/fstab

/dev/pve/root / ext3 errors=remount-ro 0 1 /dev/pve/data /var/lib/vz ext3 defaults 0 1 /dev/md0 /boot ext3 defaults 0 1 /dev/pve/swap none swap sw 0 0 proc /proc proc defaults 0 0

Перемонтируем загрузочный раздел

umount /boot mount /boot

настройка загрузочного меню grub[]

Добавим загрузочный образ initramfs

mkinitramfs -o /boot/initrd.img-`uname -r`-raid1 -r /dev/mapper/pve-root

Заменим файл загрузочного меню и создадим свой, предварительно сохранив оригинальный

cp /boot/grub/menu.lst /boot/grub/menu.lst.orig echo "default 0" > /boot/grub/menu.lst echo "timeout 5" >> /boot/grub/menu.lst echo "title Proxmox VE on soft-RAID" >> /boot/grub/menu.lst echo "root (hd0,0)" >> /boot/grub/menu.lst echo "kernel /vmlinuz-`uname -r` root=/dev/mapper/pve-root ro" >> /boot/grub/menu.lst echo "initrd /initrd.img-`uname -r`-raid1" >> /boot/grub/menu.lst

Проверим:

cat /boot/grub/menu.lst

Конвертация виртуальной машины Windows.

Создадим на хосте Proxmox виртуальную машину с необходимыми настройками и ресурсами. Создайте два жестких диска, один IDE для системного диска, второй SCSI или Virtio, в зависимости от того, какой тип планируете использовать. Диск IDE должен присутствовать обязательно, иначе виртуальная машина не загрузится. Вот такая конфигурация получилась у меня:

Теперь переходим непосредственно к конвертации. В консоли хоста Proxmox выполним команду:

Shell

qemu-img convert -f vmdk </path/to/disk.vmdk> -O raw /mnt/pve/hdd1/images/101/disk0.raw -p

| 1 | qemu-img convert-fvmdk<pathtodisk.vmdk>-Orawmntpvehdd1images101disk0.raw-p |

В команде, естественно, укажите свои параметры.

Запустится процесс конвертации диска.

После завершения конвертации нужно изменить конфиг виртуальной машины. Для этого открываем в редакторе файл конфигурации ВМ(в нашем случае ВМ имеет ID 101):

Shell

nano /etc/pve/qemu-server/101.conf

| 1 | nanoetcpveqemu-server101.conf |

Если узел Proxmox находится в кластере, путь до файла конфигурации будет выглядеть так:

Shell

nano /etc/pve/nodes/<node-name>/qemu-server/101.conf

| 1 | nanoetcpvenodes<node-name>qemu-server101.conf |

В строке ide0 укажем наш сконвертированный диск:

Сохраните изменения. Теперь можно запустить виртуальную машину.

Настройка ВМ после конвертации.

После конвертации необходимо проделать следующие действия: удалить VMtools(если они установлены) и установить необходимые драйвера.

Удаление VMtools производится через стандартную оснастку «Программы и компоненты».

Перезагрузку после удаления можно отложить.

Для установки драйверов потребуется скачать и подключить к ВМ образ с драйверами. Скачать его можно из официального источника..

После подключения образа с драйверами, перейдите в него и запустите мастер установки драйверов, выбрав нужную разрядность:

Это самый простой способ установить необходимые драйвера. Также, не лишним будет установить гостевой агент из папки guest-agent.

Теперь нам нужно переключить системный диск с устаревшего контроллера IDE на Virtio. Для этого выключаем виртуальную машину и вносим изменения в конфиг файл, который мы уже редактировали. Приведем его к следующему виду:

Обратите внимание, что нужно указать первым загрузочным устройством наш системный диск. (Думаю, что загрузочный диск, всё же, лучше разместить на шине 0, поэтому нужно заменить в файле конфигурации virtio1 на virtio0)

Диски, созданные при создании ВМ, теперь можно удалить.

После этого можно включать виртуальную машину и использовать по назначению.

Install Proxmox VE

Adapt your sources.list

Add the Proxmox VE repository:

NOTE: If you have enabled other arch (typically, i386 to run some older software) and apt-get complains about not being able to find /binary-i386: «Unable to find expected entry ‘pve/binary-i386/Packages'» you need to remove other arch or use insted the row:

deb http://download.proxmox.com/debian jessie pve-no-subscription

If it does not work for apt-get of some files, then replace http:// with ftp:// especially in the first two urls above.

Add the Proxmox VE repository key:

Update your repository and system by running:

apt-get update && apt-get dist-upgrade

Install Proxmox VE packages

Install the Proxmox VE packages

apt-get install proxmox-ve ssh postfix ksm-control-daemon open-iscsi systemd-sysv

Finally, reboot your system, the new Proxmox VE kernel should be automatically selected in the GRUB menu.

Как лучше настроить mdadm RAID под Proxmox?

Встала необходимость настроить платформу на основе Proxmox VE 3 под несколько ВМ с Debian GNU/Linux на борту. Для этих целей был приобретен HP Proliant DL 320e Gen8, и закуплено 4 SATA HDD по 1Tb каждый. Аппаратный контроллер решено было не приобретать, а объединить диски в RAID посредством mdadm. И тут возникает вопрос — как известно Proxmox «из коробки» нельзя установить на софт рейд, ввиду чего есть два варианта развития событий — ставить Proxmox на sda и после установки уже собирать массив(ы), либо устанавливать Debian Wheezy и на него уже «сверху» накатить пакеты и ядро из репозитория Proxmox. В-первом варианте легкий геморрой с переносом таблиц разделов и их самих, переносом LVM и т.д. Второй вариант проще, удобнее и позволяет легко настроить свою собственную структуру массивов, LVM, разделов и т.д. Единственное, что смущает — не содержит ли образ Proxmox, выложенный на сайте, каких-либо отличий или изменений от установки на «обычный» Debian? Также интересует — имеет ли смысл под нужды Proxmox собирать RAID1, а под данные RAID5, т.е. делать два массива, или все — как данные Proxmox так и образы ВМ загнать на один массив RAID5? На хосте будут крутиться мало нагруженные виртуалки, поэтому каких то особых к I/O нет

RAID5 выбран как баланс между надежностью и доступным дисковым пространством (а это в данном случае важно, как раз)

источник

Установка Proxmox VE на debian

- on Фев 13, 2017

-

in

Linux

Proxmox — система виртуализации, которая умеет управлять гипервизорами KVM и LXC. Соответственно поддерживает установку систем, поддерживаемых KVM (Linux, *BSD, Windows и другие) с минимальными потерями производительности и Linux без потерь.

Для установки понадобится свежеустановленный последний Debian. Скачать можно здесь. Я скачивал CD образ 64 битной версии, а точнее debian-8.7.1-amd64-CD-1.iso.torrent с этой страницы.

Так же можно скачать готовый образ с уже установленным Debian, Proxmox VE и всеми необходимыми пакетами. Называется это Bare-metal_ISO_Installer. На странице вы найдете все подробности относительно того, что оно из себя представляет и как им пользоваться.

Вернемся к установке Debian. Я записывал образ Debian на флешку и затем загружал компьютер с нее. В процессе установки стоит настроить вручную сеть (manual). Диск рекомендуется разбить следующим образом: через пункт «Configure the Logical Volume Manager» создать volume group с именем «pve». В «pve» создать три logical volumes: «swap», «root» и «data». Затем указать точкой монтирования «root» — «/», «data» — «/var/lib/vz», «swap» — swap area.

На тестовой машинке у меня сейчас 1 диск на 320 Гб и вышла следующая конфигурация:

# lvs LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert data pve -wi-ao---- 261.85g root pve -wi-ao---- 28.61g swap pve -wi-ao---- 7.63g

У вас картинка может другая, я исходил из своего железа и потребностей.

Debian установлен, перезагружаемся, добавляем Proxmox репозиторий:

echo "deb http://download.proxmox.com/debian jessie pve-no-subscription" > /etc/apt/sources.list.d/pve-install-repo.list

Если необходимо, комментируем в /etc/apt/sources.list строчку с cd диском.

Ключ репозитория Proxmox:

wget -O- "http://download.proxmox.com/debian/key.asc" | apt-key add -

Обновляемся:

apt-get update && apt-get dist-upgrade

Устанавливаем пакеты:

apt-get install proxmox-ve ssh postfix ksm-control-daemon open-iscsi systemd-sysv

Соглашаемся на предложение удалить Exim и установить postfix. Если у вас есть почтовый сервер в сети выбираем пункт satellite system, и если ваш существующий почтовый сервер является «relay host», который будет перенаправлять сообщения, отправленные proxmox сервером, конечному получателю. Если вы не знаете что выбрать — выбирайте local only.

В конце перезагружаем систему (reboot), новое ядро Proxmox VE kernel должно автоматически выбраться в GRUB меню.

Рекомендуется удалить пакет os-prober (может привести к повреждению файловой системы). Если в компьютере не будет второй операционной системы (помимо Debian с Proxmox) — удаляйте пакет смело, он вам точно не нужен:

apt-get remove os-prober

На этом установка закончена. Переходим в браузере по адресу https://IPадресProxmox:8006.

В /var/lib/vz/template/iso загружаем образы гостевых ОС.

При написании статьи использовался материал из официальной wiki проекта Proxmox — ссылка (англ).

В конечном счете получаете такую web панель управления виртуализацией Proxmox:

Заключение

Подведем итог тому, что сделали:

- Установили гипервизор proxmox на сервер под управлением Debian на программный raid1, обеспечив отказоустойчивость системы на уровне дисков.

- Настроили виртуальную сеть для виртуальных машин.

- Подключили различные storage для выполнения задач размещения и бэкапа виртуальных машин.

- Добавили и настроили виртуальные машины.

- Организовали атоматический бэкап всех ВМ.

Я постарался выбрать наиболее востребованные функции и описать их, чтобы систему можно было использовать в реальной работе и не бояться за надежность решения. Собрал необходимый минимум, но статься все равно получилась очень большая, объемная. Я не стал ее разделять на части, чтобы была целостная картина всего того, что сделали. Тут есть еще над чем поработать, особенно актуален вопрос бэкапа. Без инкрементного бэкапа неудобно хранить резервные копии на удаленном сервере, очень большой объем передаваемых данных получается. Пока я не изучал подробно этот вопрос, буду рад, если кто-то посоветует хорошее решение для KVM.

Обсуждение статьи на форуме — ссылка открывается в новой вкладке.

Вывод

Вы еще не захотели использовать систему виртуализации Proxmox? Попробуйте и вы не пожалеете. Мною используются далеко не все возможности и возможно для себя вы найдёте то, что давно хотели использовать в работе с виртуальными системами без проблем в настройках. Свобода использования, активное развитие, удобное использование и обслуживание системы однозначно ставит систему Proxmox для меня на первое место. Возможно в последующем я освою как делать репликацию между двумя отдельными системами Proxmox, но в работе это пока не требуется так как в малых и средних организациях вопрос об использовании двух серверов не стоит. Меня уже радует когда на приобретение одного хорошего сервера выделяют необходимый денежный ресурс.

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

источник