Кластер

Кластер определяет гипервизор, который будет использоваться для оказания услуг. Данный подход достаточно удобен, особенно в случае, если планируется использовать возможности различных гипервизоров по максимуму, например:

- KVM — виртуальные машины общего назначения без снимков состояния виртуальных машин, только снимки томов (AWS-like);

- XenServer

- виртуальные машины с графическими ускорителями,

- виртуальные машины с поддержкой снимков состояний и динамическим масштабированием;

- Hyper-V — виртуальные машины для предоставления услуг ОС Windows.

В рамках рассматриваемой модели развертывания, кластер — это элемент, на уровне которого ограничивается распространение отказа обслуживания за счет выделения первичного NFS-хранилища именно кластеру, что позволяет добиться того, что при отказе первичного хранилища отказ не распространяется за пределы кластера. Для достижения этой цели при добавлении первичного хранилища к облаку его область действия должна быть указана как Кластер, а не как Зона. Необходимо отметить, что поскольку первичное хранилище относится к кластеру, то живая миграция виртуальных машин может производиться только между хостами кластера.

Ограничения гипервизора KVM при использовании с панелью Apache CloudStack

Гипервизор KVM имеет ряд ограничений, которые могут препятствовать его внедрению, однако широкая распространенность показывает, что данные ограничения не рассматриваются большинством провайдеров как блокирующие. Основные ограничения следующие:

- не поддерживается динамическое масштабирование виртуальных машин, то есть для изменения количества ядер и RAM необходимо остановить машину и запустить;

- не поддерживаются полные снимки виртуальной машины вместе с дисками (это ограничение именно Apache CloudStack, поскольку сам QEMU/KVM поддерживает такую возможность);

- нет поддержки виртуальных графических ускорителей, поэтому если планируется предоставлять VDI, совместно с инфраструктурой от NVidia, то KVM не подойдет.

При планировании кластера важно исходить из конечных возможностей хранилища, которое будет использоваться с кластером. ACS позволяет использовать в рамках кластера несколько хранилищ, однако из своего опыта автор не рекомендует использовать такой вариант

Оптимальным, является подход, в рамках которого кластер проектируется как некий компромисс между потребностями и возможностями. Часто возникает желание делать кластеры слишком большими, что может приводить к тому, что домены отказа станут слишком широкими.

Проектирование кластера может производиться, исходя из понимания потребностей среднестатистической виртуальной машины. К примеру, в одном из существующих облаков пользователи, в среднем, заказывают услугу, которая выглядит как . Если попробовать рассчитать требования к кластеру, исходя из объема хранилища (без учета требований к IOPS), то можно получить следующие числа:

- Storage 24 x 1TB SSD (RAID6 + 1HS) — 21 TB

- Количество экземпляров VM — 350 = 21000 / 60

- RAM — 700 GB = 350 x 2

- Cores — 700 = 350 x 2

- Узел 2 x Xeon E5-2699V4 / 160 GB RAM — 88 Vcores (166 с переподпиской 1 к 2)

- Количество узлов (+1 резервный) — 5 + 1

Итоговый кластер будет выглядеть следующим образом:

- Хранилище: Storage 24 x 1TB SSD (RAID6 + 1HS)

- Сервер виртуализации 6 x Server 2 x Xeon E5-2699V4 / 160 GB RAM

В рамках данного кластера удастся обслужить до 350 типовых виртуальных машин. Если планируется выделение ресурсов для обслуживания 1000 машин, то необходимо развертывание трех кластеров. В случае реального облака с дифференциацией по продуктам, необходим расчет, который максимально точно отражает прогноз потребностей рынка.

Развертывание виртуальной машины на узле

-

На странице Выбор узла просмотрите оценки и щелкните узел, на котором требуется развернуть виртуальную машину, после чего нажмите кнопку Далее. Предлагаемые варианты узлов сопровождаются оценками от 0 до 5 звездочек. . Проверьте следующие параметры и при необходимости измените их.

- Предполагаемая загрузка. Предполагаемая загрузка виртуальной машины, созданной из виртуального жесткого диска без данных, рассчитывается на основе стандартных значений по умолчанию. При изменении значения предполагаемой загрузки виртуальной машины в VMM соответствующим образом обновляются предлагаемые варианты узлов и оценки.

- Сделать эту VM машиной высокой надежности. Если выбран этот параметр, для выбора доступны только узлы, расположенные в кластере.

- Сведения. Указаны состояние узла, операционная система, тип и состояние программного обеспечения виртуализации.

- Пояснение к оценке. Объяснение причин нулевой оценки узла.

- Пояснение к сети SAN или Пояснение к развертыванию и перемещению. Список всех факторов, сделавших перенос по сети хранения данных (SAN) недоступным. Виртуальная машина, сохраненная в сети SAN как доступная для развертывания путем переноса по сети SAN, не распознается в VMM, если она сохранена непосредственно в библиотеке в процессе создания или добавлена в библиотеку при ее обновлении. Во избежание этой проблемы разверните виртуальную машину на узле путем переноса по локальной сети и затем сохраните виртуальную машину в той же общей папке той же библиотеки VMM под тем же логическим номером устройства (LUN).

- На вкладке Пояснение к развертыванию и перемещению содержится пояснение, почему не может быть применено быстрое копирование файлов. Быстрое копирование файлов основано на режиме прямой передачи данных Windows (ODX). (Learn more) Дополнительные сведения.

-

На странице Настройка параметров просмотрите параметры виртуальной машины. Примите путь к виртуальной машине на узле по умолчанию или укажите другое расположение. При необходимости можно установить флажок Добавить этот путь к списку используемых по умолчанию путей к виртуальным машинам на узле. На странице Ресурсы виртуальной машины примите значения по умолчанию для виртуального жесткого диска или измените их требуемым образом. Чтобы запретить выбор других значений при размещении, щелкните значок булавки рядом с этим параметром. Этот параметр недоступен для пользователей самообслуживания.

-

На странице Выбор сетей (если она отображается) при необходимости выберите параметры сети и нажмите кнопку Далее.

-

На странице Добавить свойства задайте действие, выполняемое при запуске или остановке узла, и укажите операционную систему, которая будет установлена в виртуальной машине. Затем нажмите кнопку Далее.

-

На странице Сводка проверьте параметры и нажмите кнопку Создать.

Vmware Workstation

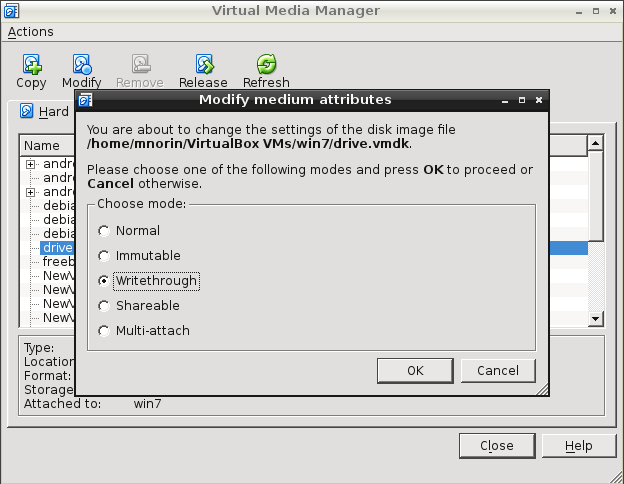

С Vmware Workstation немного по другому. Официально считается, что данная функция доступна только для vSphere. Но это немного не так. Просто не все доступно через графический интерфейс. Придется вносить руками небольшие правки в конфигурационные файлы виртуальных машин.

- Выключаем обе виртуальные машины.

- Добавляем в конфигурацию первой виртуальной машины новый жесткий диск с указанными параметрами. Физически распологаем этот жесткий диск НЕ в папке, в которой расположена виртуальная машина.При добавлении диска не забываем проследить, что бы расширение файла было .vmdk

- Далее закрываем Vmware Workstation и отредактируем файл конфигурации первой виртуальной машины (.VMX):Добавляем строки для создания второго канала SCSIscsi1.present = “TRUE”scsi1.virtualDev = “lsilogic”Изминяем дополнительный жесткий диск, который будет подключен к новому каналу:scsi1:1.present = “TRUE”scsi1:1.fileName = “C:\VMs\Share_disk\share.vmdk”scsi1:1.mode = “independent-persistent”Отключаем блокировку и кэширование дискаdisk.locking = “false”diskLib.dataCacheMaxSize = “0”

- Добавляем новый диск к второй виртуальной машине. При добавлении выбираем опцию «подключить существующий диск» и указываем диск, созданный на предыдущем этапе.

- Задаем параметры диска такие же, как и на первом этапе.

- Вносим те же изменения в файл конфигурации (.VMX) второй виртуальной машины.

- Включаем первую виртуальную машину.

- Создаем на новом диске файловую систему и подключаем диск способом, доступном ОС этой виртуальной машине.

- Включаем вторую виртуальную машину и подключаем (монтируем) диск аналогично первой ВМ.

Добавление USB устройств

Изменение Apparmor

Для получения доступа к USB устройствам требуются изменения в настройках apparmor. Отредактируйте /etc/apparmor.d/abstractions/libvirt-qemu и раскомментируйте строки.:

# WARNING: uncommenting these gives the guest direct access to host hardware. # This is required for USB pass through but is a security risk. You have been # warned. /sys/bus/usb/devices/ r, /sys/devices/*/*/usb*/** r, /dev/bus/usb/*/* rw,

После изменения настроек apparmor нужно перезапустить.:

$ sudo /etc/init.d/apparmor restart

Добавление USB устройства

Определите Vendor ID и Product ID.:

$ lsusb Bus 001 Device 001: ID 1d6b:0002 Linux Foundation 2.0 root hub Bus 005 Device 012: ID 0a5c:2110 Broadcom Corp. Bluetooth Controller Bus 005 Device 003: ID 0483:2016 SGS Thomson Microelectronics Fingerprint Reader Bus 005 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub Bus 004 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub Bus 003 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub Bus 002 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub

Для подключения Broadcom Corp. Bluetooth Controller vendor и product id это 0a5c и 2110. Эти значения нужно добавить в xml профиль. Выполните virsh edit <domain>.:

<domain type='kvm'>

<name>windowsxp</name>

…

<devices>

…

<hostdev mode='subsystem' type='usb'>

<source>

<vendor id='0x0a5c'/>

<product id='0x2110'/>

</source>

</hostdev>

</devices>

</domain>

Добавление пула

Итак, мы хотим добавить новый пул. Посмотрите на нижнюю часть левого столбца. Здесь есть несколько кнопок. Плюс отвечает за добавление пула. Кнопки play и stop отвечают за активацию и деактивацию пулов соответственно, без их удаления. А для удаления пулов предназначена последняя кнопка. Сейчас мы добавим немного дискового пространства.

Запомните: пул — это логическая группа носителей, которая может включать один или несколько дисков, каждый из которых представляет собой виртуальный диск какого-либо типа. Добавление пула производится в два этапа.

Во-первых, выберите имя и тип. Вы можете использовать директории (точки монтирования), включая устройства NFS, SCSI и iSCSI, разделы LVM и физические диски. Я пробовал использовать внешний жесткий диск, подключаемый к компьютеру по USB и отформатированный в файловую систему NTFS. Все просто работает, проблем не было.

Второй этап будет зависеть от того, что вы выбрали на первом. Для директории в файловой системе большинство пунктов будет неактивно. Просто задайте путь и на этом все.

Но если вы выбрали, например, NFS, необходимо будет ввести дополнительную информацию, такую как имя хоста, директорию для экспорта, точку монтирования и тип файловой системы.

Установка KVM

Все махинации по созданию виртуальной машины я буду проводить на ОС Ubuntu 16.04.1 LTS. Чтобы проверить поддерживает ли ваш процессов аппаратную виртуализацию на базе Intel VT/AMD SVM, выполняем:

Если терминал непустой, то значит всё в порядке и KVM можно устанавливать. Ubuntu официально поддерживает только гипервизор KVM (входит в состав ядра Linux) и советует использовать библиотеку libvirt в качестве инструмента по управлению им, что мы и будем делать дальше.

Проверить поддержку аппаратной виртуализации в Ubuntu также можно через команду:

В случае успеха, вы увидите что-то вроде этого:

Устанавливаем пакеты для работы с KVM:

Если у вас есть доступ к графической оболочке системы, то можно установить GUI менеджер libvirt:

Пользоваться virt-manager достаточно просто (не сложнее VirtualBox), поэтому в этой заметке речь пойдёт про консольный вариант установки и настройки виртуального сервера.

Развертывание виртуальной машины в частном облаке

-

На странице Выбор облака выберите частное облако для размещения виртуальной машины. Пользователь с правами администратора может выбрать узел для развертывания виртуальной машины в частном облаке. Предлагаемые варианты облаков основываются на оценке от 0 до 5. . Проверьте следующие параметры и при необходимости измените их.

- Предполагаемая загрузка. Предполагаемая загрузка виртуальной машины, созданной из виртуального жесткого диска без данных, рассчитывается на основе стандартных значений по умолчанию. При изменении значения предполагаемой загрузки виртуальной машины в VMM соответствующим образом обновляются предлагаемые варианты узлов и оценки.

- Сделать эту VM машиной высокой надежности. Если выбран этот параметр, для выбора доступны только узлы, расположенные в кластере.

- Сведения. Указаны состояние узла, операционная система, тип и состояние программного обеспечения виртуализации.

- Пояснение к оценке. Объяснение причин нулевой оценки узла.

- Пояснение к сети SAN или Пояснение к развертыванию и перемещению. Список всех факторов, сделавших перенос по сети хранения данных (SAN) недоступным. Виртуальная машина, сохраненная в сети SAN как доступная для развертывания путем переноса по сети SAN, не распознается в VMM, если она сохранена непосредственно в библиотеке в процессе создания или добавлена в библиотеку при ее обновлении. Во избежание этой проблемы разверните виртуальную машину на узле путем переноса по локальной сети и затем сохраните виртуальную машину в той же общей папке той же библиотеки VMM под тем же логическим номером устройства (LUN).

- На вкладке Пояснение к развертыванию и перемещению содержится пояснение, почему не может быть применено быстрое копирование файлов. Быстрое копирование файлов основано на режиме прямой передачи данных Windows (ODX). (Learn more) Дополнительные сведения.

-

На странице Настройка параметров просмотрите параметры виртуальной машины. Примите путь к виртуальной машине на узле по умолчанию или укажите другое расположение. При необходимости можно установить флажок Добавить этот путь к списку используемых по умолчанию путей к виртуальным машинам на узле. На странице Ресурсы виртуальной машины примите значения по умолчанию для виртуального жесткого диска или измените их требуемым образом. Чтобы запретить выбор других значений при размещении, щелкните значок булавки рядом с этим параметром. Этот параметр недоступен для пользователей самообслуживания.

-

На странице Выбор сетей (если она отображается) при необходимости выберите параметры сети и нажмите кнопку Далее.

-

На странице Добавить свойства задайте действие, выполняемое при запуске или остановке узла, и укажите операционную систему, которая будет установлена в виртуальной машине. Затем нажмите кнопку Далее.

-

На странице Сводка проверьте параметры и нажмите кнопку Создать. Убедитесь в том, что виртуальная машина была создана, щелкнув Виртуальные машины (VM) и службы > Облака, а затем выбрав облако. Виртуальная машина отображается в области Виртуальные машины .

KVM — решение с открытым исходным кодом

KVM (Kernel-based Virtual Machine) — полное решение виртуализации для платформ Linux/x86, поддерживающее аппаратные расширения (Intel VT и AMD-V).

Изначально KVM поддерживал только процессоры x86, но современные версии KVM поддерживают самые различные процессоры и гостевые ОС, в том числе Linux, BSD, Solaris, Windows и др.

KVM — простой в использовании, легкий, нетребовательный к ресурсам и довольно функциональный гипервизор. KVM позволяет в минимальные сроки развернуть площадку виртуализации. Все Wiki-ресурсы (MediaWiki, Wikimedia Foundation, Wikipedia, Wikivoyage, Wikidata, Wikiversity) используют именно это решение виртуализации.

Поскольку гостевые операционные системы взаимодействуют с гипервизором, который интегрирован в ядро Linux, у них есть возможность обращаться напрямую к оборудованию без нужды изменения гостевой ОС. Благодаря этому KVM считается довольно быстрым решением.

Конечно, KVM — не идеален, и у него есть тоже свои недостатки, и их надо учесть, прежде чем выбрать именно его. Начнем с того, что нет мощных средств для управления виртуальными машинами и сервером KVM. Средства, конечно, есть, но они не соответствуют по функционалу аналогичным средствам для других систем. Одно из лучших решений — SolusVM — универсальная панель управления виртуальными серверами KVM, Xen и OpenVZ.

Также часто отмечают не лучшую стабильность KVM при выполнении разнообразных задач с интенсивным вводом-выводом. Именно поэтому некоторые эксперты в сфере виртуализации при обзорах и сравнении гипервизоров называют KVM сырым решением, которое больше подходит для экспериментов, чем для корпоративного применения.

Если спросить у профессионалов о том, какой выбрать гипервизор, то все они посоветуют Hyper-V. Он более стабилен, специальные средства миграции виртуальной машины в нем надежнее, эффективнее применяется оборудование, нежели в Linux-KVM. Платформа Microsoft Azure построена на Hyper-V и это говорит о многом.

Использование физического диска в VirtualBox

На практике очень часто при использовании системы визуализации, применяется виртуальное дисковое пространство, что позволяет существенно экономить физическую память, а кроме того, при необходимости существенно увеличивать объемы. Рассмотрим более детально, как осуществляется использование физического диска утилитой:

- Это позволяет правильно распределить свободное пространство.

- Такие манипуляции дают возможность ускорить процедуру.

- Возможность запускать систему, как с виртуального носителя, так и из внутреннего хранилища.

На сегодняшний день благодаря этой программе вы сможете существенно упростить процесс воспроизведения объемных файлов и компонентов программного обеспечения. Разумеется, виртуальная платформа, это, не что иное, как отдельный каталог данных, зарезервированный на физическом носителе.

Перед началом работы

- Для выполнения описываемых действий необходимо быть администратором или полномочным администратором на сервере VMM либо пользователем самообслуживания.

- Если вы являетесь пользователем самообслуживания, вам требуются разрешения на развертывание с назначенным действием Сохранение и повторное развертывание. Вам необходимо сначала развернуть виртуальную машину в частном облаке, а затем сохранить ее в библиотеке.

- Настраивать параметры статических IP-адресов можно только при создании виртуальной машины на основе шаблона виртуальной машины.

- VMM можно использовать для настройки параметров доступности для виртуальной машины. Дополнительные сведения

Что такое KVM?

KVM (Kernel-based Virtual Machine) — гипервизор виртуальных машин для Linux. Не стоит его путать с системами контейнеризации, такими как докер или lxc. Это принципиально разные вещи. Гипервизор дает полную изоляцию рабочего окружения, в том числе и железа. Находясь в виртуальной машине, вы имеете в своем распоряжении полноценную операционную систему, принадлежащую только вам.

Существует несколько популярных гипервизоров, как бесплатных, так и за деньги. KVM является полностью бесплатным решением, которое очень активно используют хостеры, в том числе предоставляющие услуги облачных технологий. Так же есть неплохая реализация полноценного гипервизора kvm с интерфейсом управления — proxmox. Это готовый продукт на базе дистрибутива дебиан.

Я сегодня не буду рассматривать готовые сборки гипервизоров, а вручную установлю на Ubuntu Server нативный гипервизор KVM с минимальными надстройками над ним. У нас на выходе будет сам гипервизор, локальная сеть для его корректной работы и средства управления гипервизором и виртуальными машинами. Если вам интересно, почему мой выбор пал на именно на убунту, читайте мой обзор этой системы, а так же статью про установку ubuntu.

Начало работы

Настроить дисковые накопители

/dev/sda/dev/sdb/dev/sdbext4

- Размечаем диск, создавая новый раздел:

- Нажимаем клавишу o или g (разметить диск в MBR или GPT).

- Далее нажимаем клавишу n (создать новый раздел).

- И наконец w (для сохранения изменений).

- Создаем файловую систему ext4:

- Создаем директорию, куда будем монтировать раздел:

- Открываем конфигурационный файл на редактирование:

- Добавляем туда новую строку:

- После внесения изменений сохраняем их сочетанием клавиш Ctrl + X, отвечая Y на вопрос редактора.

- Для проверки, что все работает, отправляем сервер в перезагрузку:

- После перезагрузки проверяем смонтированные разделы:

/dev/sdb1/mnt/storage

Добавить новое хранилище в Proxmox

ДатацентрХранилищеДобавитьДиректория

- ID — название будущего хранилища;

- Директория — /mnt/storage;

- Содержимое — выделяем все варианты (поочередно щелкая на каждом варианте).

Добавить

Создать виртуальную машину

- Определяемся с версией операционной системы.

- Заранее закачиваем ISO-образ.

- Выбираем в меню Хранилище только что созданное хранилище.

- Нажимаем Содержимое ➝ Загрузить.

- Выбираем из списка ISO-образ и подтверждаем выбор нажатием кнопки Загрузить.

- Нажимаем Создать VM.

- Заполняем поочередно параметры: Имя ➝ ISO-Image ➝ Размер и тип жесткого диска ➝ Количество процессоров ➝ Объем оперативной памяти ➝ Сетевой адаптер.

- Выбрав все желаемые параметры нажимаем Завершить. Созданная машина будет отображена в меню панели управления.

- Выбираем ее и нажимаем Запуск.

- Переходим в пункт Консоль и выполняем установку операционной системы точно таким же образом, как и на обычный физический сервер.

Настроить автозапуск

- Щелкаем по названию нужной машины.

- Выбираем вкладку Опции ➝ Запуск при загрузке.

- Ставим галочку напротив одноименной надписи.

Start/Shutdown order

Шаг 4: Весёлая часть

Есть три способа получить ускоренный виртуальный дисплей VM с Windows на экране вашей машины.

- VNC или какой-то другой протокол удалённого доступа (обычно это весьма плохое решение). В этом варианте вам нужно только подключить vGPU и отключить все остальные дисплеи и видеокарты. Также выставьте настройку . Вам не нужна опция , показанная позже.

- SPICE (у меня не получилось добиться 30 FPS или выше, но работает общий буфер обмена и передача файлов между VM и хостом).

- Встроенный интерфейс QEMU на GTK+ (общий буфер обмена и передача файлов не работают, но можно добиться 60 FPS с помощью патча).

Что бы вы ни собирались использовать, вам всё равно придётся использовать второй вариант, чтобы установить драйвера для GPU. Встроенные драйвера от Microsoft не очень хорошо работают с GVT-g на момент написания поста, и часто ломаются. До того, как вы подсоедините vGPU к ВМ, желательно скачать последнюю версию драйвера от Intel(Судя по всему, Intel меняет подход к распространению драйверов, так что в будущем этот шаг, возможно, будет другим, либо станет вообще не нужным). Теперь убедитесь, что у вас создан vGPU. Откройте и замените хороший быстрый QXL на медленный Cirrus во избежание конфликтов. Чтобы подключить vGPU к ВМ, нужно открыть и где-нибудь добавить такой фрагмент:

Замечание: Когда я предоставляю XML-фрагмент вроде этого, вам по возможности следует добавить его к текущему, не заменяя ничего.

Проверьте, что вы создали уникальные UUID для всех vGPU, которые вы используете, и что номера слотов не конфликтуют ни с какими из остальных PCI-устройств. Если номер слота находится после Cirrus GPU, виртуальная машина упадёт. Теперь вы можете запустить виртуальную машину. Нужно установить , чтобы увидеть оба дисплея! Подключиться к ВМ можно с помощью команды

Один из дисплеев будет пустой или не инициализированный, второй — уже знакомый маленький не ускоренный дисплей. Раскройте его и, войдя, установите драйвер для GPU. Если вам повезёт, всё заработает сразу же. В противном случае, надо выключить и снова запустить ВМ (не перезагрузить) с помощью работающего экрана. Теперь самое время открыть терминал и запустить внутри . Эта команда выдаст вам некоторую полезную информацию о проблемах и общем ходе работы с использованием vGPU. Например, при загрузке KVM будет жаловаться на заблокированные MSR, затем вы должны получить несколько сообщений о неправильном доступе, когда vGPU инициализируется. Если их слишком много — что-то не так.

Если система загрузилась, можно открыть настройки дисплея и отключить не ускоренный экран. Пустой экран можно скрыть через меню View в . В принципе, ВМ уже можно использовать, но есть ещё пару вещей, которые можно сделать, чтобы добиться более высокого разрешения и более высокой скорости.

Утилита CRU весьма полезна. Можете поиграться с ней, и даже если вы наткнётесь на какие-то графические артефакты или даже почти целиком чёрный экран, как получилось у меня, вы можете запустить файл , идущий в комплекте с программой, чтобы перезагрузить графическую подсистему Windows. Лично я использую эту утилиту для использования более высокого разрешения на более скромном vGPU.

Чтобы добиться прекрасных 60 FPS, нужно переключиться на встроенный монитор QEMU на GTK+ без поддержки общего буфера обмена с хостом и подобных плюшек, а также изменить в нём одну строчку и пересобрать QEMU. Также понадобится добавить пачку противных аргументов командной строки в ваш XML. Удалите дисплей SPICE и видеокарту Cirrus и установите атрибут у вашего vGPU в (libvirt не поддерживает дисплей на GTK+ и не позволит загрузиться с без дисплея).

Масштабирование для HiDPI у монитора QEMU работает из рук вон плохо, поэтому мы его отключим. Также, вам понадобится установить переменную в тот номер дисплея, который вы используете. Чтобы дать пользователю, запускающему qemu, права доступа к X серверу, используйте команду:

Если это не сработало, попробуйте , но убедитесь, что вы используете файрвол. Иначе попробуйте более безопасный метод.

Если вы потерялись где-то по пути, можете посмотреть мой текущий XML для libvirt.

Настройки сети

Для того чтобы виртуальная машина начала исправно работать, вам предстоит прописать параметры сети, однако, здесь можно столкнуться с закономерным вопросом, как вычислить IP? Для этой цели можно воспользоваться достаточно простым вариантом скрипта. Далее вам потребуется обязательно присвоить значение командой «sudo virsh net-edit default». После того как эти правки будут применены к виртуалке, вы также можете прописать следующие команды: «sudo virsh net-destroy default, sudo virsh net-start default, sudo service libvirt-bin restart». Теперь, независимо от того, сколько раз вы перезапускаете сеть, она постоянно будет получать один и тот же адрес, что очень удобно в условиях использования виртуальной машины КВМ.

Если вам необходимо использовать максимальные возможности операционной системы, но при этом вы не хотите сталкиваться с проблемами при работе, то утилита виртуализации станет прекрасным дополнением к вашему набору программного обеспечения. Здесь уже предусмотрены многочисленные полезные настройки и вспомогательные инструменты, что существенным образом облегчает непосредственные задачи для пользователя при создании и последующей работе с виртуалками.