Основные команды для управления виртуальными машинами:

- xm console — вызывает первый терминал виртуальной машины

- xm create — запускает виртуальную машину на основе конфигурационного файла

- xm pause — временно останавливает виртуальную машину

- xm unpause — запускает виртуальную машину после остановки

- xm save — сохраняет состояние виртуальной машины

- xm restore — востанавливает состояние виртуальной машины

- xm reboot — перезагружает виртуальную машину

- xm shutdown — выключает виртуальную машину

- xentop — показывает текущую загрузку всех виртуальных машин

- xm list — список запущенных виртуальных машин

- xm dmesg — показывает dmesg виртуальной машины

- xm delete — удаляет виртуальную машину

- xm destroy — принудительно удаляет виртуальную машину

медиацентрпрокси для SIP

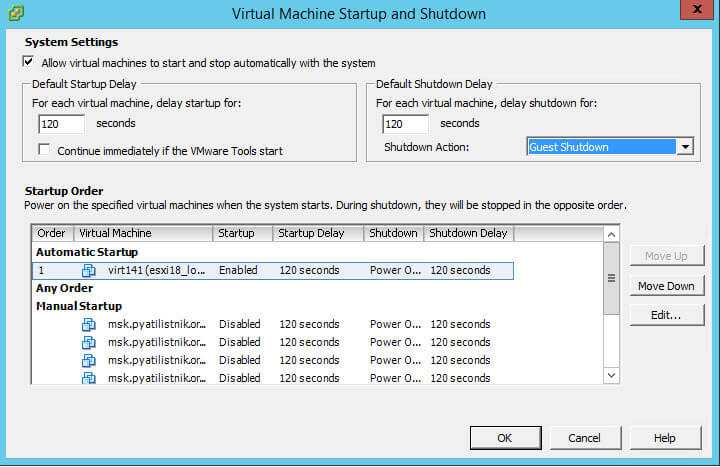

Как настроить автозапуск виртуальной машины через VMware vSphere Client

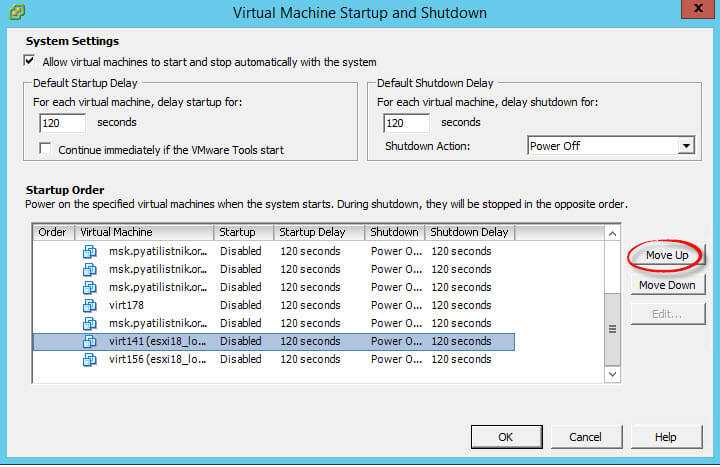

Для настройки авто запуска виртуальной машины в Vcenter 5.5 или VMware ESXi 5.5. Логинимся, выбираем нужный host и переходим в пункт Configuratin-Virtual Machine Startup/Shutdown. в правом верхнем углу жмем Properties

Как настроить автозапуск виртуальной машины в Vcenter 5.5 или ESXi 5.5-02

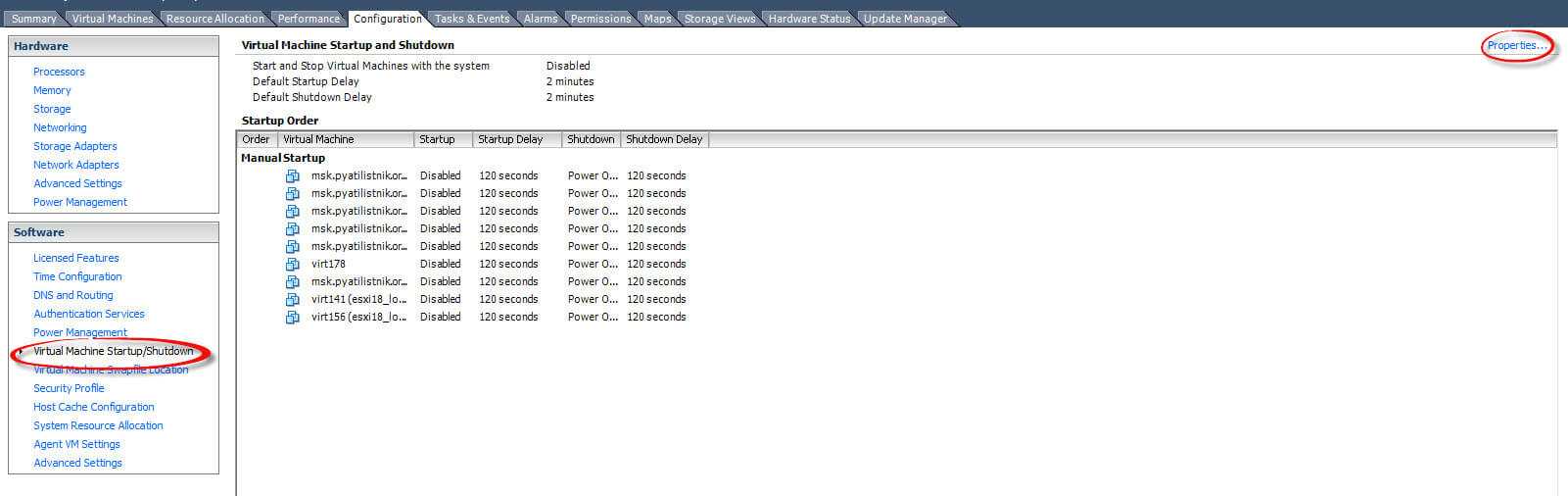

В окне Virtual Machine Startup and Shutdown, видим что все не активно, поставим для активации галку на Allow virtual machine to start and stop automatically with the system, что означает разрешить авто запуск и автоматическое выключение виртуальных машин.

Как настроить автозапуск виртуальной машины в Vcenter 5.5 или ESXi 5.5-03

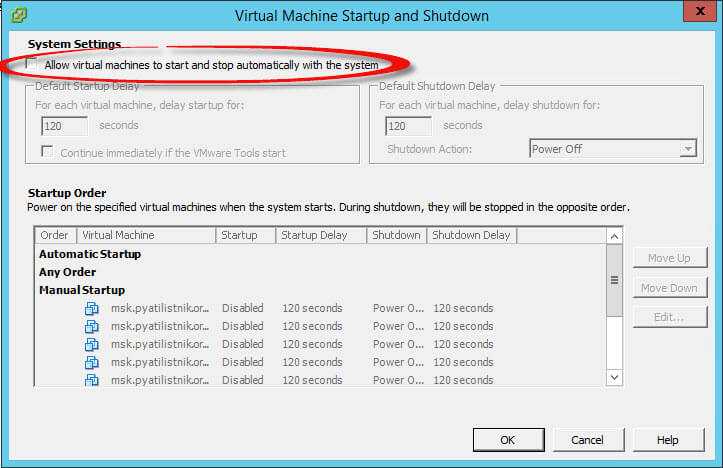

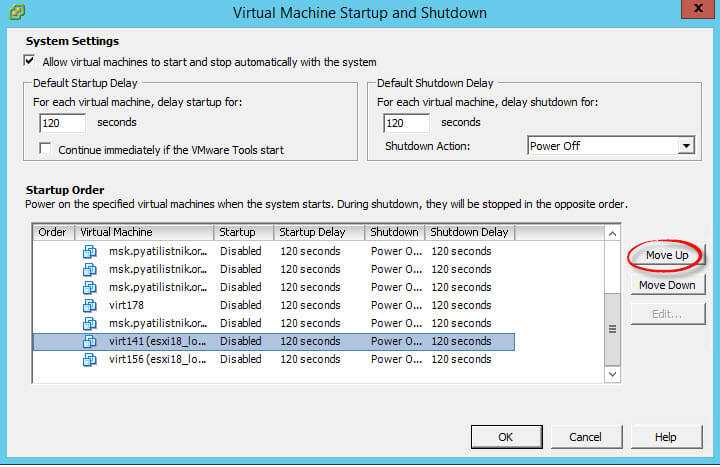

Видим что в окне Startup Order есть три значения

Выбираем нужную вам машину и с помощью кнопки Move up перемещаем ее в пункт Automatic Startup

Как настроить автозапуск виртуальной машины в Vcenter 5.5 или ESXi 5.5-04

Вы можете задать время запуска и время выключения, а так же действие при выключении в пункте Shutdown Action.

Как настроить автозапуск виртуальной машины в Vcenter 5.5 или ESXi 5.5-05

Подготавливаем виртуальную машину к запуску

Виртуальная машина domU будет загружена с помощью ядра Xen, установленного на хосте dom0, так что скопируйте модули ядра в свою файловую систему, отключите TLS и размонтируйте образ:

$ sudo cp -dpR /lib/modules/2.6.12.6-xenU /vm/vm_base/lib/modules/ $ sudo mv /vm/vm_base/lib/tls /vm/vm_base/lib/tls.disabled $ sudo umount /vm/vm_base

Вполне вероятно, что команда umount будет жаловаться, что устройство занято, хотя оно больше не используется, так что игнорируйте это предупреждение.

Теперь у вас есть одна полнофункциональная виртуальная машина domU, но, вполне вероятно, вы, в конечном итоге, захотите создать несколько виртуальных машин, так что вместо того, чтобы загружать образ, который вы только что создали, используйте его как шаблон и сделайте с него копии, которыми вы будете пользоваться.

Скопируйте образ диска для того, чтобы создать новую виртуальную машину:

$ sudo cp -a /vm/images/vm_base.img /vm/images/vm01.img $ sudo cp -a /vm/images/vm_base-swap.img /vm/images/vm01-swap.img

Установка и настройка

Все действия проводились на домашнем сервере с ubuntu-server, для других дистрибутивов возможно придется немного изменить действия.Первоначально нужно установить ядро и необходимый набор утилит:

apt-get install linux-headers-2.6.24-19-xen linux-image-2.6.24-19-xen \ linux-ubuntu-modules-2.6.24-19-xen xen-hypervisor-3.2 xen-tools

Перезагружаемся в новое ядро и устанавливаем xen-utils-3.2:

apt-get install xen-utils-3.2

Важно: если до установки xen-3.2 вы пытались установить xen-3.1, необходимо удалить все пакеты содержащие упоминания xen3.1, после становить xen-hypervisor-3.2, и перезагрузится, т.к. xen-hypervisor вносит некоторые правки для загрузки ядра

Если попытаться установить xen-utils-3.2 до перезагрузки, выйдет ошибка, т.к. xend не сможет загрузится на ядре для этого не предназначенном. Те же симптомы будут при попытки установить enomalism (web интерфейс для управления xen), т.к. он тянет за собой xen3.1

Корневая файловая система

Корневой файловой системой будет образ размером в 2 ГБ, поэтому сначала используйте dd чтобы создать образ диска, а затем используйте mkfs чтобы создать в нем файловую систему. Объема в 2 Гб должно быть достаточно для первоначального тестирования, но если вы хотите изменить размер, просто укажите другое значение аргумента , которое, умноженное на значение аргумента (размер блока), определяет общий размер диска.

Как только mkfs будет запущен, он пожалуется, что vm_base.img не является специальным блочным устройством, и попросит подтвердить, хотите ли вы независимо от этого продолжить выполнять работу. Ответьте (да):

$ sudo dd if=/dev/zero of=/vm/images/vm_base.img bs=1024k count=2000 $ sudo mkfs.ext3 /vm/images/vm_base.img

Microsoft Hyper-V

В «магическом квадранте» Gartner по виртуализации серверной инфраструктуры х86 (Magic Quadrant for x86 Server Virtualization Infrastructure), выпущенном в июле 2015 года, лидируют Micrоsoft и VMware. Xen и KVM представлены вендорами Citrix и Red Hat.способны отлично работать под Hyper-VLinux Integration Services 4.0 for Hyper-Vпакет драйверов, утилит и улучшений для гостевых ОС LinuxОсобенности Microsoft Hyper-V в Windows Server 2012 R2 Datacenter Edition

| Максимальное число одновременно работающих ВМ | 1024 |

| Максимальное число процессоров на хост-сервер | 320 |

| Число ядер на процессор хоста | Не ограничено |

| Максимальное число виртуальных процессоров (vCPU) на хост-сервер | 2048 |

| Максимальная емкость оперативной памяти на хост-сервер | 4 Тбайт |

| Память на одну ВМ | 1 Тбайт |

| Виртуальных процессоров на ВМ | 64 vCPU |

| Динамическое перераспределение памяти | Dynamic Memory |

| Дедупликация страниц памяти | Нет |

| Поддержка больших страниц памяти (Large Memory Pages) | Да |

| Централизованное управление | Да, System Center Virtual Machine Manager (SCVMM) |

| Интеграция с Active Directory | Да (через SCVMM) |

| Снимки ВМ (snapshot) | Да |

| Управление через браузер | Через портал самообслуживания |

| Обновления хост-серверов/ гипервизора | Да |

| Управление сторонними гипервизорами | Да, управление VMware vCenter и Citrix XenCenter |

| Обновление ВМ | Да (WSUS, SCCM, VMST) |

| Режим обслуживания (Maintenance Mode) | Да |

| Динамическое управление питанием | Да, Power Optimization |

| API для резервного копирования | Да, VSS API |

| Шаблоны виртуальных машин (VM Templates) | Да |

| Профили настройки хостов (Host Profiles) | Да |

| Миграция физических серверов в виртуальные машины (P2V) | Нет |

| Горячая миграция виртуальных машин | Да, без общего хранилища (Shared Nothing), поддержка сжатия и SMB3, неограниченное число одновременных миграций |

| Горячая миграция хранилищ ВМ | Да |

| Профили хранилищ | Да |

| Поддержка USB | Нет (за исключением Enhanced Session Mode) |

| Горячее добавление устройств | Только устройства хранения и/или память |

| Устройства Floppy в ВМ | 1 |

| Сетевые адаптеры/интерфейсы | 8 NIC |

| Виртуальные диски IDE | 4 |

| Емкость виртуального диска | 64 Тбайта для VHDX |

| Максимальное число узлов в кластере | 64 |

| Виртуальных машин в кластере | 8000 |

| Функции высокой доступности при сбоях хост-серверов | Failover Clustering |

| Перезапуск виртуальных машин в случае сбоя на уровне гостевой ОС | Да |

| Обеспечение доступности на уровне приложений | Да (Failover Clustering) |

| Непрерывная доступность ВМ | Нет |

| Репликация виртуальных машин | Да, Hyper-V Replica |

| Автоматическое управление ресурсами кластера | Да, Dynamic Optimization |

| Пулы ресурсов | Да (Host Groups) |

| Проверка совместимости процессоров при миграциях машин | Да, Processor Compatibility |

| Поддерживаемые хранилища | SMB3, FC, Virtual FC, SAS, SATA, iSCSI, FCoE, Shared VHDX |

| Кластерная файловая система | CSV (Cluster Shared Volumes) |

| Поддержка Boot from SAN | Да (iSCSI, FC) |

| Динамическое выделение емкости хранения (Thin Provisioning) | Да, Dynamic Disks |

| Загрузка с USB | Нет |

| Хранилища на базе локальных дисков серверов | Storage Spaces, Tiered Storage |

| Уровни обслуживания для подсистемы ввода-вывода | Да, Storage QoS |

| Поддержка NPIV | Да (Virtual Fibre Channel) |

| Поддержка доступа по нескольким путям (multipathing) | Да (DSM и SMB Multichannel) |

| Кэширование | Да, CSV Cache |

| API для интеграции с хранилищами | Да, SMI-S/SMP, ODX, Trim |

| Поддержка NIC Teaming | Да |

| Поддержка Private VLAN | Да |

| Поддержка Jumbo Frames | Да |

| Поддержка Network QoS | Да |

| Поддержка IPv6 | Да |

| Мониторинг трафика | Да |

Основные команды для управления виртуальными машинами:

- xm console — вызывает первый терминал виртуальной машины

- xm create — запускает виртуальную машину на основе конфигурационного файла

- xm pause — временно останавливает виртуальную машину

- xm unpause — запускает виртуальную машину после остановки

- xm save — сохраняет состояние виртуальной машины

- xm restore — востанавливает состояние виртуальной машины

- xm reboot — перезагружает виртуальную машину

- xm shutdown — выключает виртуальную машину

- xentop — показывает текущую загрузку всех виртуальных машин

- xm list — список запущенных виртуальных машин

- xm dmesg — показывает dmesg виртуальной машины

- xm delete — удаляет виртуальную машину

- xm destroy — принудительно удаляет виртуальную машину

Вот собственно и все. Позже возможно напишу про развертывание Xen на production-сервере с использование LVM.

Как настроить автозапуск виртуальной машины через VMware vSphere

Логинимся в ваш веб клиент. выбираем нужный хост ESXI. Нас будет интересовать пункт Manage-VM Startup/Shutdown. Жмем Edit.

Как настроить автозапуск виртуальной машины в Vcenter 5.5 или ESXi 5.5-06

Для включения также ставим галку Automatically start and stop the virtual vachine with the system

Как настроить автозапуск виртуальной машины в Vcenter 5.5 или ESXi 5.5-07

Перемещение виртуальных машин происходит с помощью стрелок

Как настроить автозапуск виртуальной машины в Vcenter 5.5 или ESXi 5.5-08

Вот так вот просто настроить автозапуск виртуальной машины в Vcenter 5.5 или ESXi 5.5.

Блог о технологиях, технократии и методиках борьбы с граблями

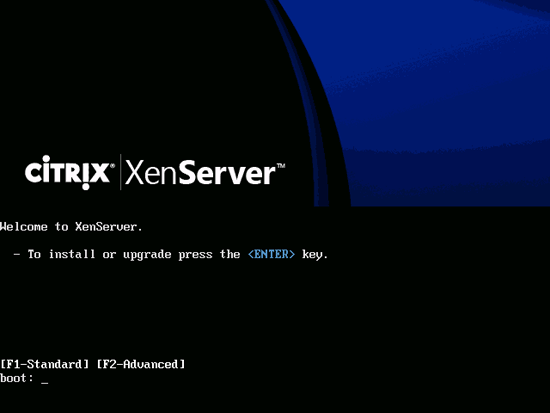

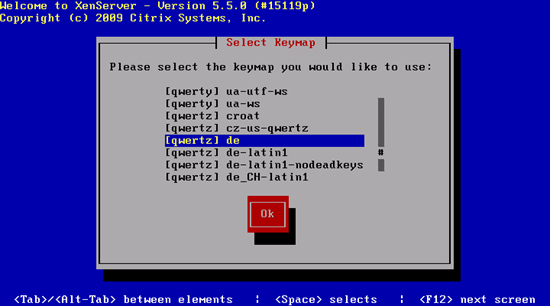

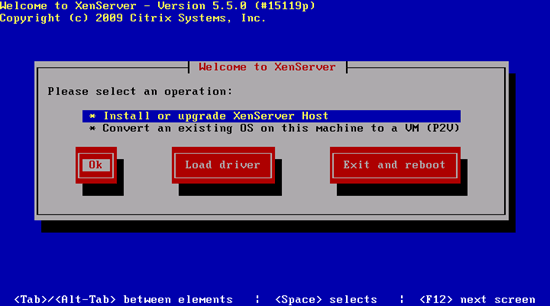

Устанавливаем XenServer

Выберите свою раскладку клавиатуры:

Выберите пункт Install or upgrade XenServer Host :

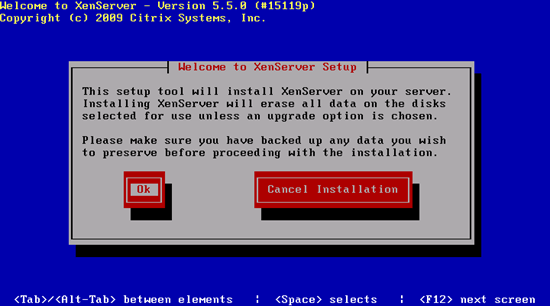

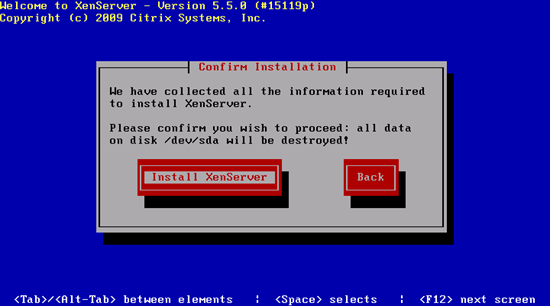

Подтвердите, что вы хотите установить XenServer (это необходимо, поскольку в процессе установки вся информация на жестком диске будет удалена):

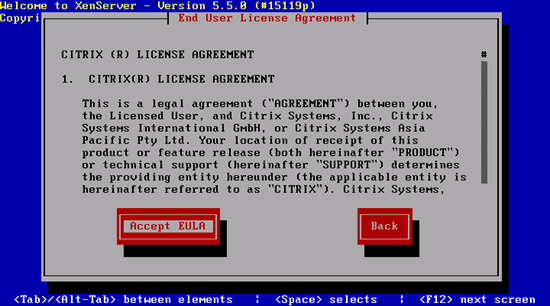

Принимаем лицензию XenServer:

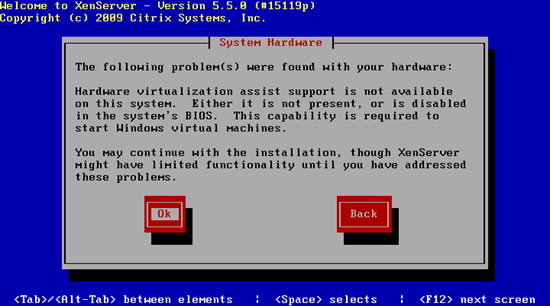

В случае, если сервер не поддерживает последние технологии виртуализации от Intel или AMD, на экране вы увидите предупреждение. Но это не помешает вам использовать различные дистрибутивы Linux в качестве виртуальных машин.

Если вы собираетесь заниматься виртуализацией исключительно Linux, то всё в порядке. Но виртуализация Windows будет недоступна без аппаратной поддержки виртуализации.

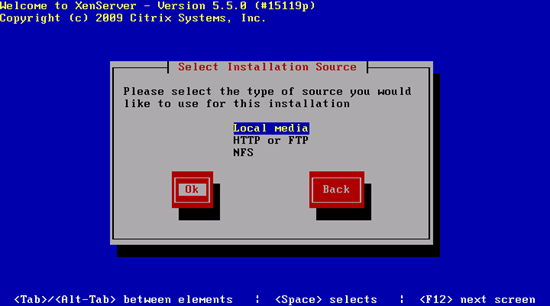

Выберите Local media в качестве источника установки:

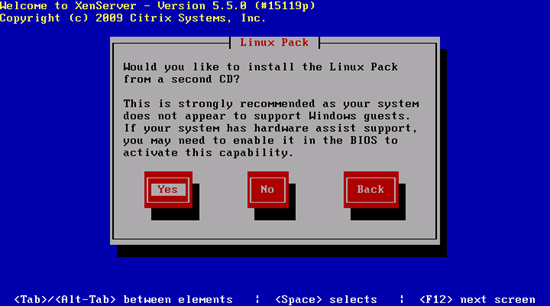

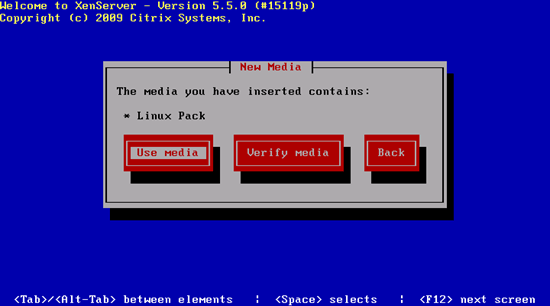

Теперь установщик спрашивает вас о втором CD, который вы закачали (для поддержки гостевых систем Linux). Выберите Yes для установки поддержки Linux:

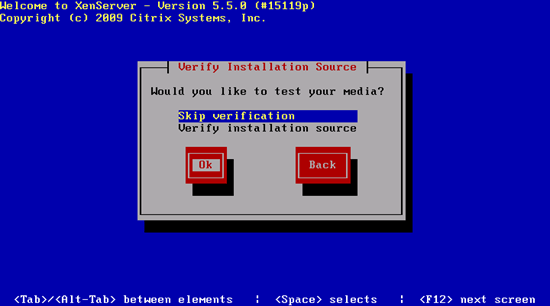

Проверку диска вы можете пропустить, посскольку она может занять длительное время:

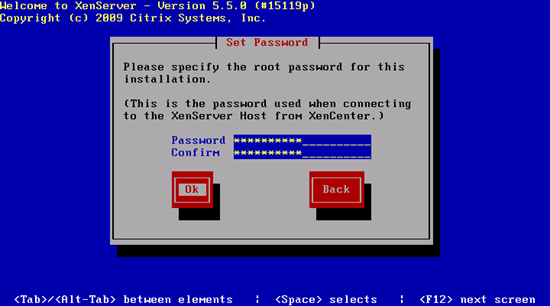

Укажите пароль пользователя root. Этот же пароль будет использоваться в дальнейшем для подключения к хосту XenServer через XenCenter:

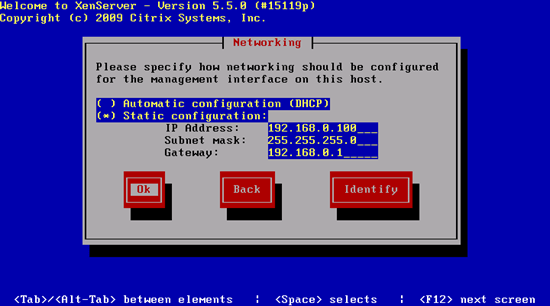

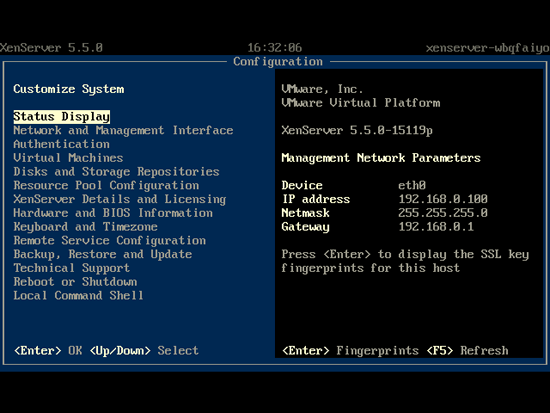

Укажите ваши сетевые настройки. Поскольку это сервер, лучше всего указать статический IP-адрес:

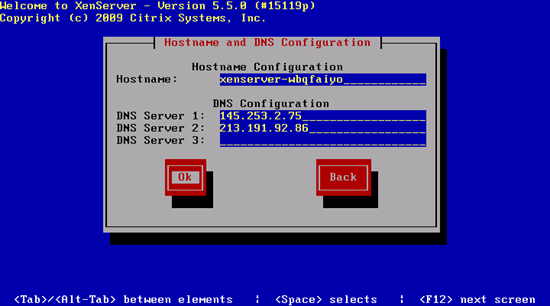

Далее, укажите имя хоста (можете оставить вариант по умолчанию) и введите до трех DNS-серверов (например, 145.253.2.75 и 213.191.92.86 ):

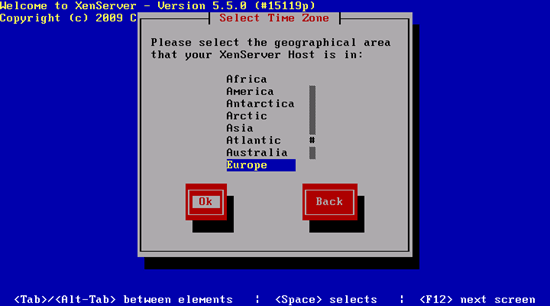

Теперь мы переходим к настройке часового пояса. Выберите свой регион.

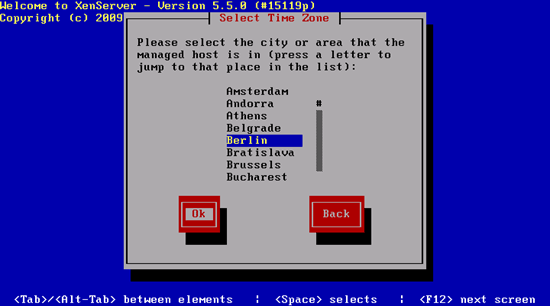

. и ближайший к серверу город:

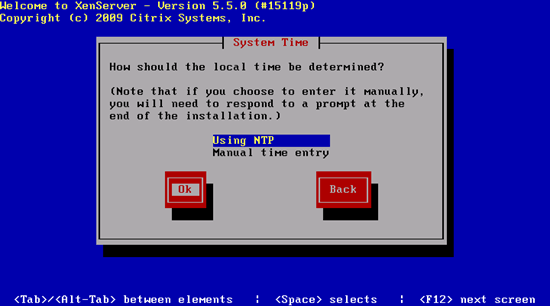

Чтобы быть уверенным в точности системного времени, следует выбрать Using NTP :

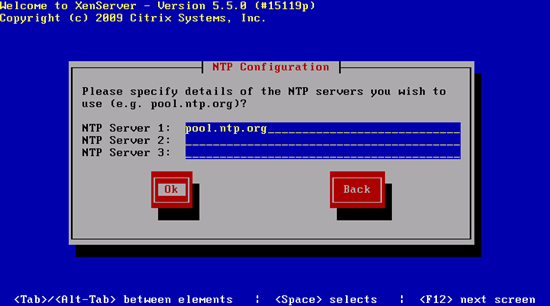

Введите до трех NTP серверов (например, pool.ntp.org ):

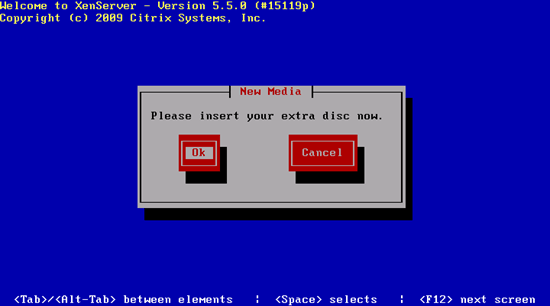

В процессе установки вас попросят вставить второй CD (для поддержки гостевых систем Linux), если ранее в процессе установки вы это указали:

Если хотите пропустить проверку второго диска, сразу жмите Use media :

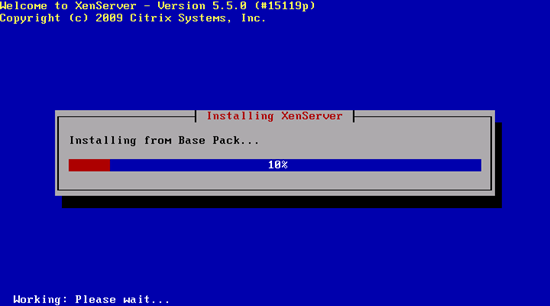

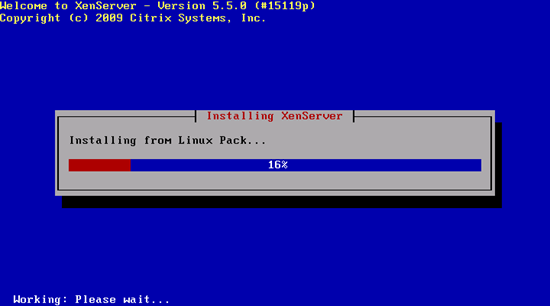

Устанавливается поддержка гостевых систем Linux:

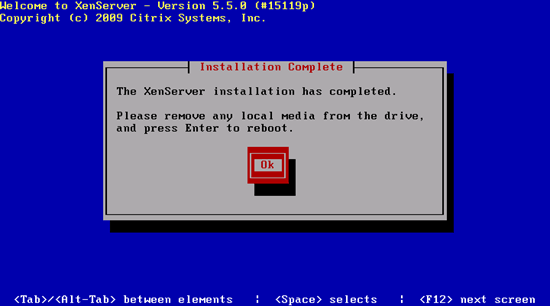

Установка XenServer завершена. Вытащите диск из дисковода и перезагрузите систему:

Автозапуск виртуальной машины в Citrix XenServer 6.2

Для 6 версии из XenCenter настроить автозапуск уже не получится, это можно сделать из консоли или добавить возможность управлять этими настройками их XenCenter.

Способ 1 (мне не нравится).

Для начала добавляем эту возможность для пула.

Если сервер всего один, нужно создать пул даже из одного сервера.

Получаем uuid нащего пула:

Устанавливаем ключ auto_poweron параметра other-config в true:

Теперь для виртуалок, которым требуется автозапуск.

Получаем uuid существующих виртуалок:

для каждой виртуалки для которой нужно включить автостарт устанавливаем ключ auto_poweron параметра other-config в true:

Если все сделано верно, после перезагрузки сервера, те виртуалки на которых установлен other-config:auto_poweron=true запустятся автоматически.

Способ 2.

Недостаток первого способа в том, что включение/выключение автозапуска виртуалок производится только из консоли. Есть возможность настроить все таким образом, чтобы управление автостартом осуществлялось из XenCenter.

К сожалению один раз в консоли полазить придется.

У меня если FAR/NC/MC не установлен — значит компьютер сломан

За автозапуск виртуалок отвечает скрипт /opt/xensource/bin/xapi-autostart-vms

Исправим его таким образом, чтобы автоматически стартовали те машины у которых имеется тег «autostart». Но сначала разберемся с пулом.

В скрипте можно заменить строку

в этом случае настройки пула относительно автостарта виртуалок будут проигнорированы, автостарт будет осуществляться только исходя из настроек самих виртуальных машин. Более того, в этом случае вовсе не требуется наличия пула.

Но возможно потребуется отключить автозапуск всех виртуалок в пуле, плюс ко всему хочется оставить совместимость со стандартным функционалом (способ 1). Для этого изменяем скрипт следующим образом.

После нее вставляем следующую:

В результате разрешить автостарт виртуальных машин в пуле можно как при помощи тега «autostart», так и стандартным способом (установка ключа auto_poweron=true).

Переходим к самим виртуалкам. Находим в скрипте строу:

После нее добавляем строку:

Готовый скрипт выглядит так:

У этого кода есть один недостаток. Если тегов у виртуальной машины несколько, то автостарт не сработает. Для устранения этого бага меняем строку запуска виртуалок на следующий код:

Настраиваем автостарт в XenCenter.

Добавляем тег «autostart». Отмечаем его. OK.

Тег «autostart» уже должен быть создан, просто его птичим. OK.

XenServer

Основанный на Xen Project Hypervisor, XenServer является платформой виртуализации серверов с открытым исходным кодом для платформ без операционной системы. Он состоит из функций корпоративного уровня, которые помогают предприятиям легко справляться с рабочими нагрузками, комбинированными ОС и сетевыми конфигурациями.

XenServer обеспечивает улучшенную виртуализированную графику с NIVIDA и Intel и позволяет запускать несколько компьютерных операционных систем на одном оборудовании.

Функционал Citrix XenServer:

- Восстановление узла

- Защита хоста от сбоев

- Мультисерверное управление

- Управление динамической памятью

- Интеграция Active Directory

- Администрирование и контроль на основе ролей (RBAC)

- Пулы смешанных ресурсов с маскированием ЦП

- Контроллер распределенного виртуального коммутатора

- Встроенное в память кэширование операций чтения

- Живая миграция виртуальных машин и хранилище XenMotion

- Если вас интересуют подробности, вы можете прочитать этот PDF.

Технологии и системы

-

OpenVZ

Технология заключается в выполнении различных систем с разными настройками и корневой системой под одним ядром. Данная технология часто используется при предоставлении услуги VDS/VPS. Т.к. ядро по сути одно и тоже, потеря производительности минимальна, но выбор систем ограничивается дистрибутивами linux’а с одним ядром. Существует платный вариант данной системы с большим количеством функций: Virtuozzo. -

Xen

В основе лежит технология паравиртуализации. Вкратце: гостевая система специально подготавливается для работы с Xen, и соответственно получается довольно небольшая потеря производительности. В качестве гостевой системы может выступать Linux (ядро гостевой системы может отличатся от ядра основной системы), FreeBSD, NetBSD, OpenBSD, OpenSolaris, Plan 9 и другие. Также возможен запуск практически любой системе через технологии виртуализации Intel/AMD, но нужен процессор с поддержкой данных архитектур. Мой сервер, в отличии от ноутбука как оказалось не поддерживает данные технологии, по этому данный метод виртуализации расcматриваться не будет. -

VirtualBOX/VMWare/Qemu и подобные системы эмуляции.

Данные системы обеспечивают эмуляцию, ценой потери производительности, по этому они рассматриваться не будут.

Настройка автоматического запуска виртуальной машины на хосте Redhat

Список доступных виртуальных машинДля начала давайте перечислим все доступные виртуальные машины в нашей хост-системе:

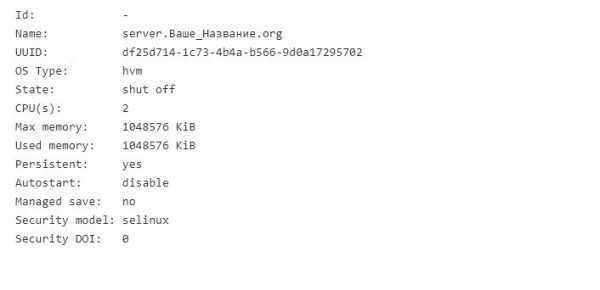

# virsh list --all Id Name State ---------------------------------------------------- - server.Ваше_Название.org shut off

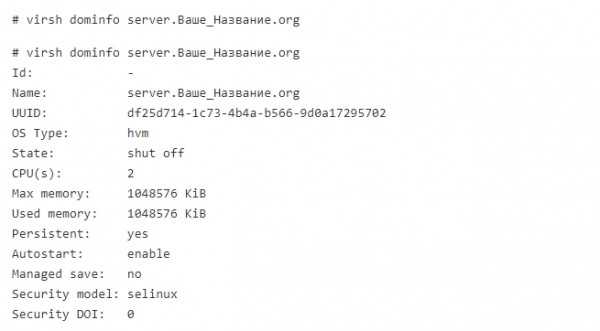

Чтобы проверить, настроена ли данная виртуальная машина для запуска после запуска системы хоста:

# virsh dominfo server.Ваше_Название.org

Кроме того, для просмотра списка всех виртуальных машин, которые уже настроены на автозапуск:

# ls /etc/libvirt/qemu/autostart/

Включить автоматический запуск виртуальной машины

Чтобы включить автоматический запуск вышеуказанной виртуальной машины KVM, выполните следующую команду linux :

# virsh autostart server.linuxconfig.org Domain server.Ваше_Название.org marked as autostarted

Если virsh команда недоступна / не установлена, для настройки austostart просто создайте новую символическую ссылку в /etc/libvirt/qemu/autostart/ каталоге с помощью ln команды. Пример:

# ln -s /etc/libvirt/qemu/server.Ваше_Название.org.xml /etc/libvirt/qemu/autostart/server.Ваше_Название.org.xml

и перезагрузите гипервизор при необходимости:

# systemctl reload libvirtd

Убедитесь, что автозапуск включен:

# virsh dominfo server.Ваше_Название.org

Отключить автозапуск виртуальной машины

Чтобы отключить автозапуск виртуальной машины, выполните:

# virsh autostart --disable server.Ваше_Название.org Domain server.Ваше_Название.org unmarked as autostarted

или просто используйте unlink команду для удаления символической ссылки виртуальной машины из /etc/libvirt/qemu/autostart/ каталога:

Сетевой Bridge для kvm

Настройка сети для виртуальных машин kvm может быть настроена различными способами. Я как минимум 3 наиболее популярных знаю:

- Виртуальные машины выходят во внешний мир через сам хост kvm, на котором настроен NAT. Этот вариант вам будет доступен сразу после установки kvm. Ничего дополнительно настраивать не надо, так как сетевой бридж для этого virbr0 уже будет добавлен в систему. А в правилах iptables будет добавлен MASQUERADE для NAT.

- Одна из виртуальных машин превращается в шлюз и через нее осуществляется доступ во внешний мир для всех виртуальных машин. Наиболее гибкий способ управления сетью для vm, но в то же время требует больше времени на настройку и набор знаний по работе с сетями.

- Для виртуальных машин kvm создается отдельный сетевой бридж во внешнюю сеть. Они напрямую получают в нее сетевой доступ.

Последний вариант наиболее простой и удобный, поэтому настроим сеть для виртуальных машин таким образом. Для этого нам нужно установить дополнительный пакет на host.

sudo apt install bridge-utils

Теперь на хосте приводим сетевые настройки в /etc/netplan к следующему виду.

network:

ethernets:

ens18:

dhcp4: false

dhcp6: false

version: 2

bridges:

br0:

macaddress: 16:76:1a:3b:be:03

interfaces:

- ens18

dhcp4: true

dhcp6: false

parameters:

stp: true

forward-delay: 4

Здесь будьте очень внимательны. Не выполняйте изменения сетевых настроек, не имея прямого доступа к консоли сервера. Очень высок шанс того, что что-то пойдет не так и вы потеряете удаленный доступ к серверу.

В предложенном наборе правил netplan у меня один сетевой интерфейс на хосте гипервизора — ens18. Он изначально получал настройки по dhcp. Мы добавили новый сетевой бридж br0, в него добавили интерфейс ens18. Так же мы указали, что br0 будет получать сетевые настройки по dhcp. Я указал mac адрес для того, чтобы он не менялся после перезагрузки. Такое может происходить. Адрес можно указать любой, не принципиально. Я сделал похожий на адрес физического сетевого интерфейса.

Теперь надо применить новые настройки.

sudo netplan apply

Сразу после этого вы потеряете доступ к серверу по старому адресу. Интерфейс ens18 перейдет в состав bridge br0 и потеряет свои настройки. А в это время бридж br0 получит новые сетевые настройки по dhcp. IP адрес будет отличаться от того, что был перед этим на интерфейсе ens18. Чтобы снова подключиться удаленно к гипервизору kvm, вам надо будет пойти на dhcp сервер и посмотреть, какой новый ip адрес ему назначен.

Если у вас нет dhcp сервера или вы просто желаете вручную указать сетевые настройки, то сделать это можно следующим образом.

network:

ethernets:

ens18:

dhcp4: false

dhcp6: false

version: 2

bridges:

br0:

macaddress: 16:76:1a:3b:be:03

interfaces:

- ens18

addresses:

- 192.168.25.2/24

gateway4: 192.168.25.1

nameservers:

addresses:

- 192.168.25.1

- 77.88.8.1

dhcp4: false

dhcp6: false

parameters:

stp: true

forward-delay: 4

В этом случае после применения новых настроек, гипервизор kvm будет доступен по адресу 192.168.25.2.

Обращайте внимание на все отступы в конфигурационном файле netplan. Они важны

В случае ошибок, настройки сети применены не будут. Иногда эта тема очень напрягает, так как не получается сразу понять, где именно в отступах ошибка. В этом плане yaml файл для настроек сети гипервизора как-то не очень удобен.

Далее еще один важный момент. Чтобы наш kvm хост мог осуществлять транзит пакетов через себя, надо это явно разрешить в sysctl. Добавляем в /etc/sysctl.d/99-sysctl.conf новый параметр. Он там уже есть, надо только снять пометку комментария.

net.ipv4.ip_forward=1

Применяем новую настройку ядра.

sudo sysctl -p /etc/sysctl.d/99-sysctl.conf net.ipv4.ip_forward = 1

С настройкой сети гипервизора мы закончили. На данном этапе я рекомендую перезагрузить сервер и убедиться, что все настройки корректно восстанавливаются после перезагрузки.

Как настроить запуск виртуальных машин VMware Workstation и Server при старте Windows

Как настроить запуск виртуальных машин VMware Workstation и Server при старте Windows

Многие пользователи настольной платформы VMware Workstation и серверной VMware Server хотели бы настроить автоматический запуск виртуальных машин при старте Windows, но до входа в систему. Это необходимо для того, чтобы в случае перезагрузки компьютера виртуальные машины автоматически бы «поднимались», и не требовалось бы вмешательства администратора.

Все это можно достать в пакете Windows 2003 Resource Kit tools (rktools.exe), загруженном с сайта Microsoft.

Установите этот пакет и после этого скопируйте instsrv.exe и srvany.exe в каталог windows\system32. После этого необходимо перезагрузить компьютер.

Теперь найдите исполняемый файл VMware Workstation или Server (например, c:\program files\vmware\vmware workstation\vmware.exe) и главный конфигурационный файл виртуальной машины (например, C:\mymachines\WinXp\winxp.vmx).

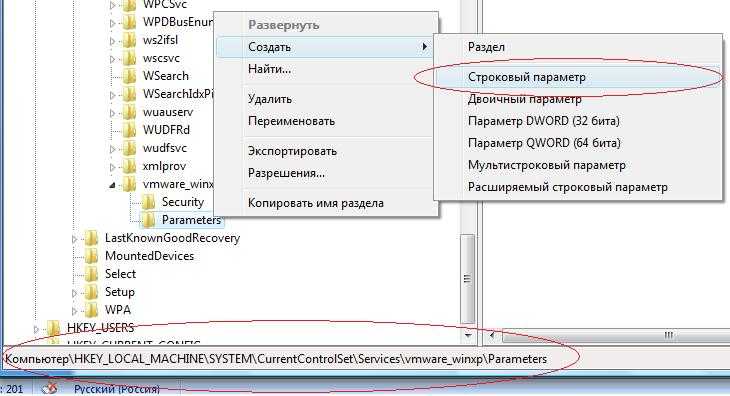

Далее выполните следующую команду в командной строке, чтобы вручную создать новую службу:

Instsrv vmware_winxp C:\windows\system32\srvany.exe, здесь vmware_winxp – имя вашей новой службы.

После этого идем в редактор реестра (regedit.exe) и находим этот ключ

Создаем новый ключ Parameters (для этого нажимаем правой клавишей на имя службы, далее New->Key).

Создаем новое значение типа String Value в ключе Parameters, как показано на рисунке:

Называем значение Application.

Два раза нажимаем на значение и в поле Value Data прописываем путь к VMware Workstation, ключ запуска виртуальной машины и путь к vmx-файлу виртуальной машины (не забывайте про кавычки):

«C:\program files\vmware\VMware Workstation\VMware.exe» –x «C:\mymachines\WinXp\winxp.vmx»

Теперь после того, как вы создали службу, необходимо настроить параметры запуска для нее. Для этого выполните Start->Run и напишите services.msc.

Вы увидите список имеющихся служб. Найдите созданную вами службу vmware_winxp и два раза кликните на нее. Появятся свойства службы. Установите на вкладке General тип запуска Automatic, перейдите на вкладку Log On. Здесь установите для параметра Log on as значение Local System account и обязательно отметьте галку Allow service to interact with desktop.

Теперь можно протестировать автозапуск виртуальной машины, выбрав из контекстного меню сервиса пункт Run. При запуске виртуальной машины может выскочить запрос о смене уникального идентификатора (UUID), надо выбрать выбрать пункт Create. Кроме того, надо убедиться, что все ненужные устройства для виртуальной машины отключены (Virtual CD-ROM, floppy). Также добавьте в vmx-файл следующую строчку для отключения всплывающих подсказок:

Теперь все – перезагружайте компьютер и тестируйте автозапуск виртуальной машины в качестве службы.

Подготавливаем виртуальную машину к запуску

Виртуальная машина domU будет загружена с помощью ядра Xen, установленного на хосте dom0, так что скопируйте модули ядра в свою файловую систему, отключите TLS и размонтируйте образ:

Вполне вероятно, что команда umount будет жаловаться, что устройство занято, хотя оно больше не используется, так что игнорируйте это предупреждение.

Теперь у вас есть одна полнофункциональная виртуальная машина domU, но, вполне вероятно, вы, в конечном итоге, захотите создать несколько виртуальных машин, так что вместо того, чтобы загружать образ, который вы только что создали, используйте его как шаблон и сделайте с него копии, которыми вы будете пользоваться.

Скопируйте образ диска для того, чтобы создать новую виртуальную машину:

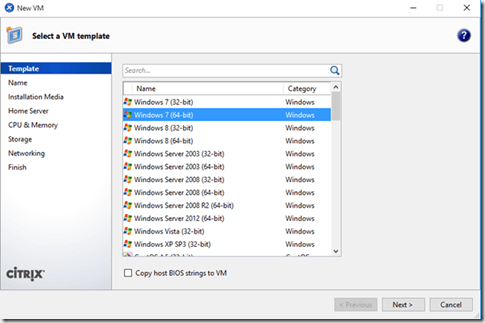

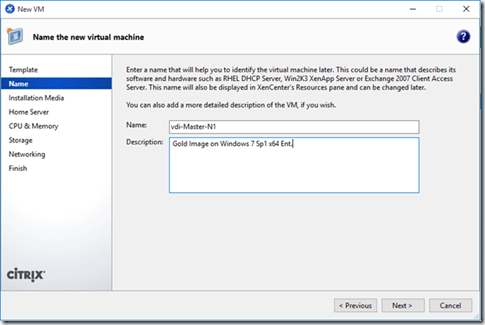

Создание виртуальной машины через XenCenter

Для развертывания виртуальных машин в инфраструктуре VI используется консоль управления гипервизором и виртуальными машинами Citrix XenCenter.

При запуске консоли необходимо выполнить подключение к одному из пулов виртуальных машин.

Далее необходимо воспользоваться главным меню (раздел VM), либо щелкнуть правой кнопкой мыши по активному пулу машин и выбрать из контекстного меню пункт New VM.

После этого будет запущен мастер создания виртуальных машин.

Далее необходимо выбрать один из подготовленных шаблонов виртуальных машин.

Далее заполняется имя машины в пуле и ее описание. Информация о тэгах и размещении в каталоге будет доступна после создания виртуальной машины.

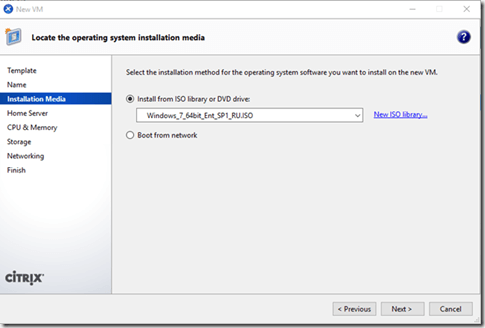

Далее указывается источник загрузки образа операционной системы, как правило это дистрибутив операционной системы в виде ISO-образа.

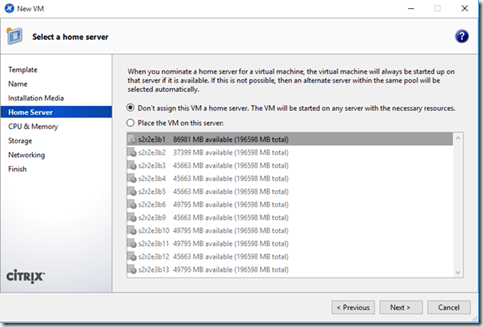

Далее выбирается привязка виртуальной машин к целевому гипервизору. Требуется это как правило для проектировании плана аварийного восстановления виртуальной инфраструктуры VI, чтобы можно был запускать определенные блейд-сервера по очередности в порядке приоритета. Помимо этого дополнительно настраивается приоритет запуска самой виртуальной машины.

В нашем случае нет необходимости привязывать виртуальную машину к конкретному серверу, поэтому выберем пункт:

и мастер пула сам на основе своей логики и загрузки доступных гипервизоров выберет где лучше запустить виртуальную машину.

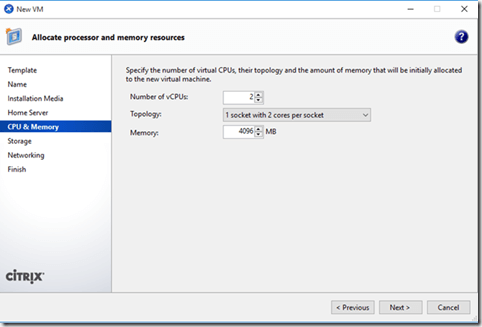

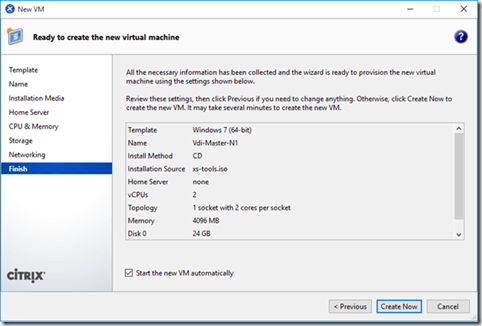

В следующем окне необходимо указать количество виртуальных ресурсов, предназначенных для создаваемой машины, например для обеспечения оптимального быстродействия системы Microsoft Windows 7 x64 SP1 Enterprise, выбрано 2 vCPU (т.е. 2 виртуальных процессора) на одном сокете и 4 ГБ оперативной памяти (объем указывается в мегабайтах).

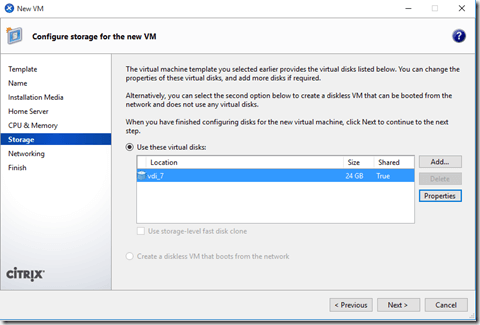

Далее выбирается объем диска и его размещение на логических диска – LUN, презентованных (т.е. доступных) текущему пулу и всем серверам.

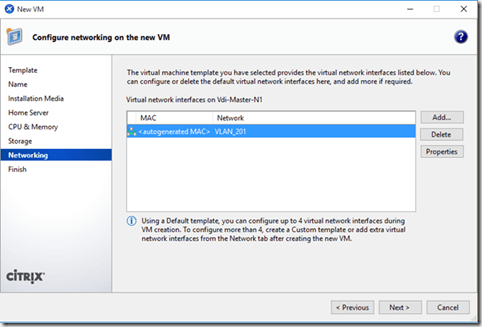

Далее выбирается сетевой интерфейс, указывает MAC адрес и принадлежность к виртуальной сети (т.е. указывается VLAN). Кроме этого можно указать скорость интерфейса и настроить QoS, если требуется.

Если все параметры указаны правильно то, стоит обратит внимание на галочку Start the new VM automatically, установка которой приведёт к автоматическому запуску виртуальной машины после ее создания. Если требуется выполнить более тонкую настройку машины, то данную галочку лучше убрать и далее нажать кнопку Create Now

Далее необходимо перейти к созданной машине указа ее имя в поле Search, выполнить необходимые дополнительные настройки и запустить для выполнения процедуры установки системы.

Технологии и системы

-

OpenVZ

Технология заключается в выполнении различных систем с разными настройками и корневой системой под одним ядром. Данная технология часто используется при предоставлении услуги VDS/VPS. Т.к. ядро по сути одно и тоже, потеря производительности минимальна, но выбор систем ограничивается дистрибутивами linux’а с одним ядром. Существует платный вариант данной системы с большим количеством функций: Virtuozzo. -

Xen

В основе лежит технология паравиртуализации. Вкратце: гостевая система специально подготавливается для работы с Xen, и соответственно получается довольно небольшая потеря производительности. В качестве гостевой системы может выступать Linux (ядро гостевой системы может отличатся от ядра основной системы), FreeBSD, NetBSD, OpenBSD, OpenSolaris, Plan 9 и другие. Также возможен запуск практически любой системе через технологии виртуализации Intel/AMD, но нужен процессор с поддержкой данных архитектур. Мой сервер, в отличии от ноутбука как оказалось не поддерживает данные технологии, по этому данный метод виртуализации расcматриваться не будет. -

VirtualBOX/VMWare/Qemu и подобные системы эмуляции.

Данные системы обеспечивают эмуляцию, ценой потери производительности, по этому они рассматриваться не будут.