Введение

Современные операционные системы Windows 7, Windows Server 2008 и всё, что старше, умеют подключаться напрямую на iSCSI target. Проблема только в том, как инициализировать удаленное блочное устройство при включении ПК.

Вспомним, что почти все современные сетевые карты умеют загружаться по технологии PXE. А вот с iSCSI дружат в основном только дорогостоящие серверные сетевые карты, например Intel. Однако, существует как минимум два open source проекта gPXE и iPXE позволяющий при загрузке ПК подключаться iSCSI устройствам. Последний, к слову, форк первого, с немного доработанной системой вывода ошибок и дополнительными опциями.

Есть много способов, как загружаться через gPXE и iPXE. В данном посте мы будем рассматривать загрузку с использованием iPXE и подключением для него необходимых скриптов в процессе загрузки.

Суть такова — при запуске компьютера PXE загрузчик получает необходимые настройки через DHCP и загружает PXELINUX, который задает необходимые параметры и загружает iPXE, который, в свою очередь, выступает iSCSI инициатором и передает управление диску. До момента инициализации блочного устройства передачу файлов по сети обеспечивает протокол TFTP.

Для чего мы загружаем PXELINUX?

Установка Windows Admin Center для управления Hyper-V 2019

Теперь нам надо передать скачанный файл на гипервизор и установить панель управления. Ранее мы разрешили подключение к Windows Hyper-V Server 2019 по rdp. Подключимся к нему, чтобы было удобно выполнять команды на самом гипервизоре.

По-умолчанию, на гипервизоре включен firewall, который блокирует внешние подключения. Вы можете либо полностью его отключать и включать с помощью команд в консоли cmd:

netsh advfirewall set currentprofile state off netsh advfirewall set currentprofile state on

Либо разрешить некоторые команды удаленного управления, которые позволят в том числе передавать файлы на гипервзиор по smb. Следующие команды нужно вводить не в обычной консоли, а powershell. Для этого наберите команду powershell в стандартной консоли, которая загружается после подключения по rdp, а потом сами команды.

powershell Set-NetFirewallRule -DisplayGroup 'Windows Management Instrumentation (WMI)' -Enabled true -PassThru Set-NetFirewallRule -DisplayGroup 'Remote Event Log Management' -Enabled true -PassThru Set-NetFirewallRule -DisplayGroup 'Remote Volume Management' -Enabled true -PassThru

Эти разрешения нам понадобятся позже, когда мы будем подключаться стандартными системными останстками для управления Hyper-V Server 2019.

Заходим на любой диск гипервизора через обычный проводник windows и передаем туда скачанный инсталлятор WindowsAdminCenter1904.1.msi. В качестве авторизации используем учетную запись администратора.

Возвращаемся на гипервизор, идем в паеку C:/Soft и запускаем переданный файл.

Запускается инсталлятор Windows Admin Center. Там все просто, можно использовать дефолтные значения. Я лично ставлю галку Разрешить Windows Admin Center изменять параметры доверенных узлов для этого компьютера и Перенаправлять трафик с HTTP-порта 80 на HTTPS-порт. После установки можно в браузере переходить по адресу https://10.20.1.14.

Чтобы страница открылась, введите учетные данные администратора hyper-v сервера. Выбираем единственный сервер, вводим еще раз данные администратора и подключаемся к панели управления сервером. Дальше, думаю, уже сами разберетесь. Не буду подробно останавливаться на описании функционала Windows Admin Center.

В разделе Виртуальные машины, можно создать виртуалку и запустить ее. Единственное, не забудьте установочный iso образ загрузить на гипервизор. Можно в ту же папку, куда загружали установщик админ центра. Единственное, вот на чем остановлюсь. Давайте создадим виртуальный коммутатор, для того, чтобы виртуальная машина получила доступ к сети.

Для этого идем в раздел Виртуальные коммутаторы и жмем на кнопку Создать.

Указываете имя коммутатора и его тип. Из-за перевода Admin Center на русский язык, трудно уловить суть названий, поэтому лучше все же качать английскую версию. Я уже установил русскую, поэтому расскажу на основе ее. Существует 3 типа коммутаторов:

- Личный (private) для связи только между виртуальными машинами, без доступа к гипервизору и сетью за ним.

- Внутренний (internal) — почти то же самое, что и личный, только доступ к коммутатору может иметь и гипервизор, но по прежнему нет доступа к внешней сети.

- Внешний (external) по сути это обычный сетевой бридж, куда входит реальный сетевой интерфейс гипервизора. Этот тип коммутатора используется для доступа виртуальных машин во внешнюю сеть.

В моем примере у меня только один сетевой интерфейс на гипервизоре. Я создам один коммутатор типа Внешний (External).

Получилось вот так.

Теперь этот коммутатор можно использовать в виртуальных машинах для доступа во внешнюю сеть.

В принципе, на этом настройку Windows Hyper-V Server 2019 можно и закончить. Если вас функционал Windows Admin Center устраивает, пользуйтесь им. В целом, в нем есть все необходимое, но мне он не нравится. Очень тормозной интерфейс, приходится два раза авторизовываться, чтобы подключиться. У меня не всегда получается через браузер открыть консоль виртуальной машины. Какие-то ошибки бывают, зависания.

Я предпочитаю использовать классические оснастки для управления гипервизором. Если вы так же как и я, предпочитаете их, переходим к следующему способу подключения и управления Hyper-V Server 2019. Для этого нам понадобится компьютер или виртуальная машина с Windows 10. Можно ее установить прямо на этом же гипервизоре. Иногда я так делаю для удобства. Получается автономный гипервизор со всем необходимым для управления.

Широкое Распространение Windows Server в режиме ядра

Microsoft потратила значительное время на разработку новых инструментов и управление ими для Windows Server 2019. В течение долгого времени громоздкое управление Windows Server Core было главным препятствием для его внедрения по всем направлениям.

Однако в сочетании с Windows Server 2019 Microsoft представила Windows Admin Center, который является полнофункциональным, всеохватывающим инструментом управления следующего поколения, позволяющим гибко и современно управлять всеми выпусками Windows Server, включая Core.

Любые оговорки, которые ИТ-администраторы ранее имели по поводу использования Windows Server Core в своих средах из-за отсутствия возможностей управления, больше не являются проблемой с Центром администрирования Windows.

Действия на стороне хоста

Первоначально необходимо один раз установить на сервере компонент Multipath IO, который обеспечивает работу многопутевого ввода/вывода. Данное действие производится через стандартный диалог Add Roles and Features

При использовании протокола iSCSI необходимо выполнить:

- В свойствах Software iSCSI Initiator необходимо указать адреса таргетов, т.е. СХД на вкладке Discovery должны быть введены все используемые IP адреса контроллеров СХД

- После обнаружение таргетов к ним необходимо подключиться при помощи кнопки Connect. Отметим важные детали:

- Необходимо добавить подключаемые таргеты в список Избранных, чтобы в случае разрыва соединения происходило автоматическое переподключение

- Необходимо включить поддержку MPIO

- Хотя автоматическое определение маршрутизации в большинстве случаев работает корректно, мы все же рекомендуем не пренебрегать явным указанием с какого сетевого интерфейса сервера необходимо подключаться к конкретному таргету (Advanced Settings)

- Если через один и тот же сетевой интерфейс сервера производится работа с нескольким портами СХД, то подключение через Connect нужно проделать для каждого пути

При использовании протокола Fibre Channel все гораздо проще: достаточно выполнить Rescan для обнаружения нового тома. В нашем примере это том с LUN ID = 1, доступный по 4 путям. Как и в случае с iSCSI следует убедиться, что для диска установлена политика Round Robin, при которой все доступные пути до СХД будут использоваться равномерно.

Важное замечание касательно конфигурирования MPIO. По умолчанию Windows видит дисковые устройства по отдельности, т.е

каждый путь к устройству – это отдельный диск.

Чтобы ОС «склеила» все одинаковые диски в единое устройство, необходимо в стандартной оснастке MPIO добавить новое устройство как многопутевое. Для iSCSI устройств устанавливается отдельное разрешение. По окончании настройки потребуется перезагрузить сервер. Данную настройку необходимо произвести однократно для каждой СХД. После чего все вновь презентованные диски будут опознаваться ОС как многопутевые.

В случае использования кластера из нескольких хостов Windows Server, действия, описанные выше, необходимо повторить на каждом из хостов. После чего диски, появившиеся в системе, можно добавлять в дисковые ресурсы кластера.

Видео

Пока я не осилил запись и монтаж видео по новой версии. Кому недостаточно текста и очень хочется посмотреть видео по установке и настройке Hyper-V, предлагаю ролик от прошлой версии. Там почти все то же самое. По крайней мере основное так точно.

Watch this video on YouTube

Онлайн курс Основы сетевых технологий

Теоретический курс с самыми базовыми знаниями по сетям. Курс подходит и начинающим, и людям с опытом. Практикующим системным администраторам курс поможет упорядочить знания и восполнить пробелы. А те, кто только входит в профессию, получат на курсе базовые знания и навыки, без воды и избыточной теории. После обучения вы сможете ответить на вопросы:

- На каком уровне модели OSI могут работать коммутаторы;

- Как лучше организовать работу сети организации с множеством отделов;

- Для чего и как использовать технологию VLAN;

- Для чего сервера стоит выносить в DMZ;

- Как организовать объединение филиалов и удаленный доступ сотрудников по vpn;

- и многое другое.

Уже знаете ответы на вопросы выше? Или сомневаетесь? Попробуйте пройти тест по основам сетевых технологий. Всего 53 вопроса, в один цикл теста входит 10 вопросов в случайном порядке. Поэтому тест можно проходить несколько раз без потери интереса. Бесплатно и без регистрации. Все подробности на странице .

Бэкап виртуальных машин Hyper-V

Ранее я уже рассказывал про программу HVBackup для бэкапа виртуальных машин. Она замечательно работает с Windows Hyper-V Server 2019, приведенная статья полностью актуальна. Для работы программы необходимо установить на гипервизоре .Net Framework 3.5 с помощью команды powershell:

Install-WindowsFeature NET-Framework-Core

Программа, конечно, монструозная, весит много, ставится долго, но зато никаких заморочек. Все настраивается легко и понятно через интерфейс программы. Для установки требуется .Net Framework 4.6. Можете установить заранее сами, либо инсталлятор veeam сам предложит вам это сделать.

После установки запускаете программу. Добавляете новый сервер:

Указываете, что это Standalone Hyper-V server, добавляете учетные данные и дожидаетесь окончания установки необходимых компонентов на hyperv сервере. После этого можно создать резервную копию виртуальной машины. Для этого выбираете гипервизор, виртуальную машину и либо делаете сразу бэкап, либо создаете запланированное задание.

Дальше указываете различные параметры бэкапа, в том числе место, куда он будет сделан. Не буду останавливаться на этом подробно. У Veeam отличная документация и интуитивно понятный интерфейс. Пример хорошего продукта. За то, что он есть под Hyper-V, я и люблю последний. Очень не хватает аналога Veeam для KVM или Xen.

Плюсы и минусы Hyper-V

Расскажу немного, почему я постоянно пользуюсь hyper-v наравне с другими гипервизорами (в основном KVM). В общем и целом мне нравится этот гипервизор, поэтому я и решил внимательно проработать вопрос установки и первоначальной настройки для дальнейшего использования по мере необходимости. К плюсам hyper-v в целом и бесплатной версии в частности я отношу следующие моменты:

Поддержка всех популярных ОС. Нет никаких проблем с совместимостью, нет необходимости отдельно ставить какие-то драйвера или тулсы. Поддержка hyper-v присутствует во всех windows системах, в ядре линукс, не помню точно с какой версии, но все современные системы ее имеют, в ядре freebsd, начиная с 10-й версии. То есть вы просто берете установочный диск и ставите систему на hyper-v, больше от вас ничего не требуется.

Много различных способов бэкапа виртуальных машин. Это могут быть простые скрипты, бесплатные программы, либо полноценные платные версии крупных компаний, специализирующихся на программном обеспечении для бэкапа

Обращаю на это особое внимание. По мне так это самый существенный плюс Hyper-v.

Стандартная панель управления гипервизором, которую можно установить на компьютер под управлением windows

К ней прибавился web доступ через windows admin center. Расскажу об этом далее подробнее.

В основе Hyper-V Server популярная серверная система, с которой понятно и удобно работать. К примеру, чтобы загрузить или забрать файл с гипервизора, вам достаточно расшарить на нем папку стандартным образом, как вы это делаете в любой windows системе.

Hyper-V можно установить на псевдорейды, такие как встроенный рейд контроллер от intel, или собрать софтовый рейд средствами самой ОС Windows.

Полнофункциональная бесплатная версия, правда без удобных средств управления.

Удобная работа со снепшотами из коробки. Не надо думать над форматами файлов, как в KVM. В Hyper-V он один и отлично поддерживает снепшоты.

Это мое личное мнение, основанное на опыте работы с малыми и средними компаниями, где нет каких-то особенных требований к надежности и доступности сервисов. Где используются несколько серверов с виртуальными машинами, не всегда есть домен windows. Конечно, помимо плюсов, есть и минусы. Первый и главный для меня минус — первоначальная настройка. Нельзя просто взять, установить Hyper-V Server и начать им пользоваться. Необходимо производить какие-то непонятные и не очевидные действия на хосте и управляемой машине. Дальше вы поймете, что я имею ввиду. Но преодолев это препятствие, можно спокойно использовать виртуальную инфраструктуру, основанную на бесплатном гипервизоре от microsoft.

Второй минус — нет никакой возможности пробросить USB в виртуальную машину. Подчас это очень неудобно и вынуждает использовать что-то другое, вместо Hyper-V. Не понимаю, почему в Microsoft за столько лет не могут это исправить. Запрос очень актуальный и злободневный, особенно у нас, где повсеместно используется 1С с USB ключами.

Настройка ядра Windows Server Core и установка роли Hyper-V

Как и в случае любой новой установки Windows Server, существует множество различных базовых параметров конфигурации, которые необходимо настроить перед использованием сервера в production. Это включает в себя изменение имени сервера, присоединение к домену (если домен присутствует), настройку IP-адреса, удаленное управление, обновление Windows и многие другие задачи.

Как уже упоминалось выше, утилита sconfig уже давно является утилитой для настройки ядра Windows Server Core. Она имеет меню управления в основной версии операционной системы, которое помогает преодолеть разрыв между конфигурацией рабочего стола Windows и опытом только командной строки.

Заметное изменение заключается в том, что Microsoft удалила утилиту sconfig из автоматического запуска. Это изменение, несомненно, преднамеренно, поскольку Центр администрирования Windows является новым предпочтительным средством как для настройки, так и для управления ядром Windows Server Core.

Есть несколько вещей, которые я обычно люблю делать с помощью sconfig, чтобы быстро запустить сервер и получить возможность удаленно управлять им и устанавливать роли/функции. Это включает в себя:

- Изменение сетевых настроек (IP-адрес и т. д)

- Измените имя сервера

- Присоединяйтесь к домену

- Включить RDP

- Включить Удаленное Управление

Присоединившись к домену, включив RDP и включив удаленное управление, вы можете легко подключиться к серверу через Центр администрирования Windows, чтобы завершить настройку. Также возможно установить роль Hyper-V.

Существует несколько способов установки роли Hyper-V:

- использовать PowerShell

- Центр Администрирования Windows

Перед началом работы

ознакомьтесь с дисковые пространства прямыми требованиями к оборудованию и считывает этот документ, чтобы ознакомиться с общим подходом и важными примечаниями, связанными с некоторыми шагами.

Соберите следующие сведения:

Вариант развертывания. дисковые пространства Direct поддерживает с объединением, также известное как агрегированное. Ознакомьтесь с преимуществами каждого из них, чтобы решить, что вам подходит. Шаги 1-3 ниже применимы к обоим вариантам развертывания. Шаг 4 необходим только для согласованного развертывания.

Имена серверов. Ознакомьтесь с политиками именования в Организации для компьютеров, файлов, путей и других ресурсов. Необходимо подготавливать несколько серверов, каждый из которых имеет уникальные имена.

Доменное имя. Ознакомьтесь с политиками организации по именованию доменов и присоединению к домену. Вы присоедините серверы к домену, и вам потребуется указать имя домена.

Сеть RDMA. Существует два типа протоколов RDMA: iWarp и Роце

Обратите внимание, какой из них использует сетевые адаптеры, и если Роце, также обратите внимание на версию (v1 или v2). Для Роце также обратите внимание на модель коммутатора верхнего уровня.

ИД ВИРТУАЛЬНОЙ ЛС

Запишите идентификатор виртуальной ЛС, который будет использоваться для сетевых адаптеров ОС управления на серверах, если таковые имеются. Его можно получить у администратора сети.

Установка Hyper-V Server 2012 R2

Первым делом скачиваем свежую версию гипервизора с сайта Microsoft. Скачивать нужно обязательно английскую версию. Во-первых, в русской были некоторые баги, хотя их могли и пофиксить уже, но дело не только в этом. Для автоматизации и упрощения настройки Hyper-V Server 2012 R2 мы будем использовать скрипты, написанные для английской версии, в русской они работать не будут. Я сначала поставил русскую версию, потратил какое-то время, потом плюнул и переустановил систему.

Установка достаточно банальна и ничем принципиально не отличается от любой другой установки windows. Скачивается образ, с него загружается система и устанавливается. В конце установки нас встречает консоль с настройками Hyper-V Server 2012 R2:

Сразу же дам подсказку на случай, если вы Hyper-V Server Configuration console закроете. Запустить снова ее можно командой sconfig. Мне пришлось потратить прилично времени, чтобы найти как это сделать без перезагрузки сервера.

Подключение диска iSCSI

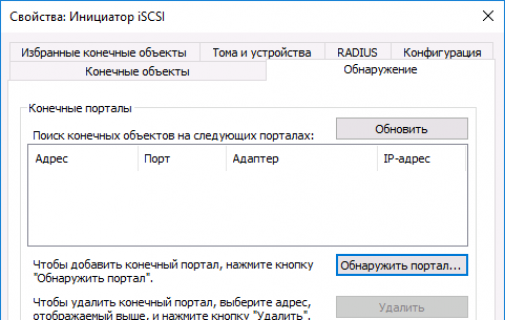

1. Зайдите в «Панель Управления -> Администрирование » и запустите Инициатор iSCSI .

2. В разделе «Свойства Обнаружение » и нажмите кнопку «Обнаружить портал ».

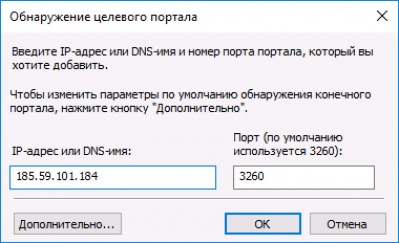

3. В открывшемся окне заполните поле «IP адрес» сервера iSCSI.

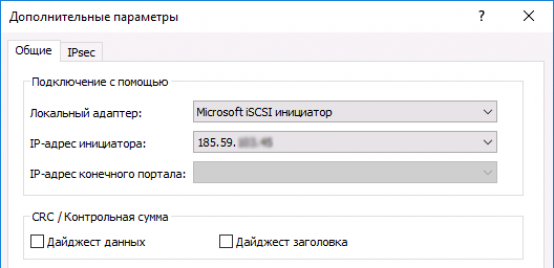

4. Откройте раздел дополнительных параметров подключения к серверу (нажмите кнопку «Дополнительно »). Выберите значения полей «Локальный адаптер » и «IP-адрес инициатора », как на рисунке ниже (где IP-адрес инициатора — это IP вашего локального сетевого адаптера, через который разрешено подключение к серверу iSCSI).

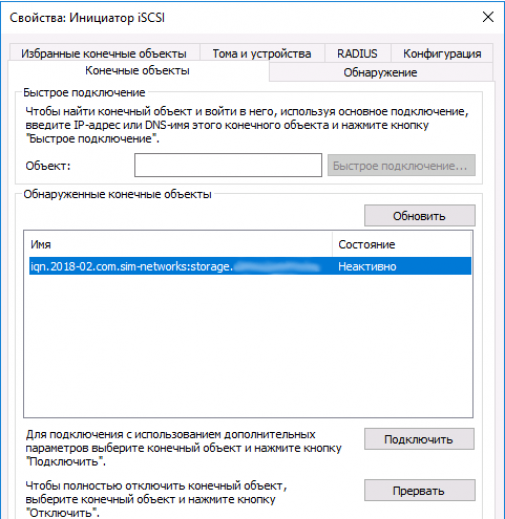

5. Сохраните настройки, убедитесь в получении изображения, подобного приведенному ниже:

6. В разделе «Свойства » инициатора iSCSI перейдите на вкладку «Конечные объекты », выберите появившийся объект с неактивным состоянием и нажмите кнопку «Подключить ».

7. В открывшемся окне «Подключение к конечному объекту », нажмите кнопку «Дополнительно… »

8. Заполните поля раздела, как на рисунке ниже. Параметры «Имя» и «Секрет» — это «Логин» и «Пароль» из письма, отправленного вам при активации услуги.

9. Сохраните настройки. Убедитесь, что значение поля «Состояние » обнаруженного конечного объекта – «Подключено », как на рисунке ниже. Выйдите из раздела «Свойства » Инициатора iSCSI, сохранив настройки.

Действия на стороне СХД

Необходимые настройки на СХД можно разделить на два этапа:

- Настройка интерфейсов

- Настройка пространства хранения

Настраивать интерфейсы требуется в основном в случае использования протокола iSCSI: необходимо задать IP адреса портов на вкладке iSCSI Ports. IP адреса портов должны быть из разных подсетей, чтобы однозначно маршрутизировался трафик на стороне хоста.

В случае использования интерфейса Fibre Channel ничего настраивать, как правило, не нужно.

Далее необходимо создать пространство хранения. Сначала создается пул – группа физических накопителей, работающих совместно. Пулов в пределах СХД может быть несколько. Накопители внутри пула объединяются в соответствии с выбранным при его создании уровнем RAID, обеспечивая заданную надежность. Пулы создаются на вкладке Pools → Create Pool, где запускается пошаговый мастер.

- Необходимо выбрать тип пула: thick (место выделяется сразу) или thin (место выделяется по мере заполнения). Отметим, что thick пулы являются более производительными.

- Выбрать конкретные диски

- Уровень RAID

- Указать параметры физических накопителей, влияющие на их производительность.

Рекомендуется использовать установки по умолчанию для максимальной скорости:- Enable Disk Write Cache

- Enable Disk Read-ahead

- Enable Disk Command Queuing

- Disable Disk Standby

Помимо обычных пулов Qsan поддерживает создание AutoTiering пулов при условии активации соответствующей лицензии. С принципом работы таких пулов можно ознакомиться в отдельной статье.

После создания пула(ов) необходимо создать тома (volume): Volumes → Create volumes. Также запустится пошаговый мастер создания тома.

Необходимо задать требуемый размер тома, тип тома выбирается как RAID volume. Рассмотрим их более подробно.

- Block Size – размер блока, который будет эмулироваться для хоста. Для Windows Server рекомендуется задать значение 4КБ как наиболее оптимальное.

- Background I/O Priority – приоритет фоновых задач (расширение, миграция и пр.)

- Erase Volume Data – необходимость зануления создаваемого тома. Значение Fast Erase соответствует записи нулей в первый гигабайт пространства, может быть полезно при повторном использовании дисков с целью удалить остатки предыдущих данных (стереть таблицы размещения). Full Erase – запись нулей по всему объему, полезно для достижения максимальной производительности в случае использования RAID 1/10.

- Enable Cache Mode (Write-back Cache) – включение кэша СХД. Очень сильно влияет на производительность.

- Enable Video Editing Mode – снижение производительности ради более стабильных результатов. Если не предполагается использование тома в системах видеонаблюдения, лучше выключить данный параметр.

- Enable Read-ahead – включение упреждающего чтения. Положительно влияет на производительность.

- Enable Fast RAID Rebuild – при активации данной настройки система будет вести трекинг всех записываемых блоков, чтобы понимать, сколько реальных данных записано на том. В случае выхода из строя диска в составе RAID группы во время ребилда не будут копироваться пустые блоки, что может ускорить данный процесс. Однако стоит помнить, что использование Fast Rebuild снижает производительность при случайном доступе.

Заключительным этапом в настройке СХД является публикация томов для доступа к ним со стороны хостов через функционал LUN mapping → Map LUN.

- Необходимо выбрать протокол доступа: FCP (Fibre Channel) или iSCSI. Доступ к одному и тому же тому может быть только через один протокол.

- Allowed Host – список хостов, которым разрешен доступ к тому. По умолчанию разрешено всем (*). Однако рекомендуется всегда явно указывать разрешения для исключения конфликтов доступа и, соответственно, повреждения файловой системы. Для Fibre Channel указываются WWPN хостов (с возможностью выбора из всех доступных в SAN сети). Для iSCSI указываются IQN хостов. В случае нескольких хостов они добавляются по кнопке Add Host. Со стороны Windows значения WWPN и IQN можно узнать через консольную (PowerShell) команду Get-InitiatorPort

Добавление и назначение файлов драйверов

Если вы планируете назначать настраиваемые драйверы, файлы драйверов должны присутствовать в библиотеке. Драйверы в библиотеке можно пометить, чтобы впоследствии их можно было фильтровать по тегу. После добавления файлов при настройке профиля физического компьютера можно указать файлы драйверов. VMM установит указанные драйверы при установке операционной системы на физический компьютер.

В профиле физического компьютера можно выбрать фильтрацию драйверов по тегам или указать фильтрацию драйверов с совпадающими идентификаторами Plug and Play (PnP) на физическом компьютере. Если выбрана фильтрация драйверов по тегам, VMM определяет применяемые драйверы путем сопоставления тегов, назначенных драйверам в библиотеке, с тегами, назначенными в профиле. Если выбрать фильтрацию драйверов с совпадающими идентификаторами PnP, не требуется назначение настраиваемых тегов.

- Найдите пакет драйвера, который нужно добавить в библиотеку.

- В общей папке библиотеки, находящейся на сервере библиотеки, связанном с группой, в которой нужно развернуть физические компьютеры, создайте папку для хранения драйверов, а затем скопируйте в нее пакет драйвера.

- Настоятельно рекомендуется создать отдельную папку для каждого пакета драйвера и не смешивать ресурсы в папках драйверов. Если в одну и ту же папку включены другие ресурсы библиотеки, такие как ISO-образы, VHD-файлы или сценарии с расширением имени файла INF, сервер библиотеки VMM не сможет обнаружить эти ресурсы. Кроме того, при удалении пакета драйвера INF из библиотеки VMM удалит всю папку, в которой находится INF-файл драйвера.

- В консоли VMM откройте рабочую область «Библиотека». В области Библиотека > Серверы библиотек разверните сервер библиотеки, где находится общая папка, правой кнопкой мыши щелкните общую папку библиотеки, а затем выберите пункт Обновить. После обновления библиотеки появится папка, созданная для хранения драйверов.

- При необходимости назначьте теги. В области Библиотека разверните папку, созданную для хранения драйверов в предыдущей процедуре, а затем щелкните папку, которая содержит пакет драйвера.

- В области Физические объекты библиотеки правой кнопкой мыши щелкните INF-файл драйвера, а затем выберите пункт Свойства.

- В разделе Свойства: имя файла драйвера > Настраиваемые теги введите разделенные точкой с запятой настраиваемые теги или щелкните Выбрать, чтобы назначить доступные теги или создать и назначить новые. Если щелкнуть Выбрать и Новый тег, после нажатия кнопки ОК можно изменить имя тега. Например, если добавлен файл драйвера сетевого адаптера, можно создать тег с именем «модель_сервера модель_сетевого_адаптера», где «модель_сервера» — это модель сервера, а «модель_сетевого_адаптера» — это модель сетевого адаптера.

Настройка Hyper-V Server 2012 R2

Через консоль задаем необходимые настройки:

1. Указываем рабочую группу. Я рассматриваю вариант настройки отдельно стоящего сервера, не входящего в доменную сеть. В домене настройки будут другие. 2. Указываем имя сервера. 3. Создаем дополнительного пользователя. Можно работать от administrator, который создается по-умолчанию, но лучше создать для управления отдельного пользователя. Позже будет понятно, зачем. 4. Включаем удаленное управление. 5. Включаем автоматическое обновление. 6. Скачиваем и инсталлируем обновления. 7. Разрешаем подключаться по rdp всем клиентам, с любой версией протокола. 8. Задаем сетевые настройки. 9. Устанавливаем время и дату.

На этом первоначальная настройка закончена. Пока все понятно и логично.

А вот что делать дальше я не совсем понял. Я работал со всеми современными гипервизорами: xen, esxi, kvm и всегда все было более ли менее понятно, что делать дальше, но не в этом случае.

Пользоваться командной строкой в windows, по-моему мнению, очень неудобно. Команды длинные, неочевидные, настроить гипервизор и создать виртуальные машины через командную строку невероятно долго и нудно. К тому же копи-паст часто глючит, длиннющие команды приходится набирать вручную. Пришлось гуглить, чтобы хотя бы понять, как мне загрузить образ системы на сервер, чтобы хоть как-то начать установку виртуальной машины.

Предварительные требования к отказоустойчивому кластеру Hyper-V

- Два сервера с установленной ОС Windows Server 2016 (желательно чтобы количество памяти и CPU на обоих серверах было одинаково)

- Установленная роль Hyper-V с компонентами Failover Cluster и MPIO ( iSCSI по необходимости)

- Как минимум по 2 сетевых карты на каждом сервере (одна сетевая карта будет использоваться для управления и через нее будет идти трафик ВМ, вторая – для взаимодействия хостов между собой – трафик CSV и Heartbeat)

- Общее дисковое хранилище, подключенное к обоим серверам (в этом примере дисковый массив подключается к каждому серверу через 2 порта Fiber Channel, при этом компонент MPIO нужен для того, чтобы каждый сервер видел только одно подключение к диску, а не два)

- Как минимум один диск (LUN) с общего хранилища презентован обоим сервера, инициализирован и отформатирован.

Советы по использованию средства VMConnect

Ознакомьтесь с указанными ниже сведениями об использовании VMConnect:

| Для этого… | Сделайте это… |

|---|---|

| Отправка щелчков мыши или клавиатурного ввода на виртуальную машину | Щелкните в любом месте окна виртуальной машины. При подключении к работающей виртуальной машине указатель мыши может отображаться в виде маленькой точки. |

| Возврат щелчков мыши или клавиатурного ввода на физический компьютер | Нажмите клавиши CTRL+ALT+СТРЕЛКА ВЛЕВО, а затем переместите указатель мыши за пределы окна виртуальной машины. Это сочетание клавиш для отпускания кнопки мыши можно изменить в параметрах Hyper-V в диспетчере Hyper-V. |

| Отправка сочетания клавиш CTRL+ALT+DELETE на виртуальную машину | Выберите Действие > Ctrl+Alt+Delete или воспользуйтесь сочетанием клавиш CTRL+ALT+END. |

| Переключение из режима окна в полноэкранный режим | Выберите Представление > Полноэкранный режим. Чтобы перейти обратно в режим окна, нажмите клавиши CTRL+ALT+BREAK. |

| Создание контрольной точки для получения сведений о текущем состоянии компьютера, чтобы устранить неполадки | Выберите Действие > Контрольная точка или используйте сочетание клавиш CTRL+N. |

| Изменение параметров виртуальной машины | Выберите Файл > Параметры. |

| Подключение к (ISO-файлу) DVD-образа или к (VFD-файлу виртуального гибкого диска) | Выберите Медиа.

Виртуальные гибкие диски не поддерживаются для виртуальных машин 2-го поколения. Дополнительные сведения см.в статье Should I create a generation 1 or 2 virtual machine in Hyper-V? (Следует ли создавать виртуальные машины 1-го и 2-го поколения в Hyper-V?). |

| Использование локальных ресурсов узла на виртуальной машине Hyper-V, например, USB-устройства флэш-памяти | На узле Hyper-V включите режим расширенного сеанса, с помощью VMConnect подключитесь к виртуальной машине и перед подключением выберите нужный локальный ресурс. Описание конкретных шагов см. в статье Use local resources on Hyper-V virtual machine with VMConnect (Использование локальных ресурсов на виртуальной машине Hyper-V с VMConnect). |

| Изменение сохраненных параметров VMConnect для виртуальной машины | Выполните следующую команду в Windows PowerShell или в командной строке: |

| Запрещение пользователю VMConnect получать доступ к сеансу VMConnect другого пользователя |

.

Отсутствие включенного режима расширенного сеанса может привести к угрозе безопасности и конфиденциальности. Если пользователь подключился и вошел на виртуальную машину через VMConnect, а другой авторизированный пользователь подключается к той же виртуальной машине, то сеанс перехватывается вторым пользователем и будет прерван у первого. Второй пользователь сможет просматривать рабочий стол, документы и приложения первого пользователя. |

| Управление службами интеграции или компонентами, которые позволяют виртуальной машине обмениваться данными с узлом Hyper-V | На узлах Hyper-V под управлением Windows 10 или Windows Server 2016 нельзя управлять службами интеграции с помощью VMConnect. Дополнительную информацию об этом см. в следующих разделах: — Turn an integration service on or off using Hyper-V Manager (Включение или отключение службы интеграции в диспетчере Hyper-V); — (Запуск и остановка службы интеграции в гостевой учетной записи Windows);- (Запуск и остановка службы интеграции в гостевой учетной записи Linux); — (Своевременное обновление служб интеграции). Сведения об узлах под управлением Windows Server 2012 или Windows Server 2012 R2 см. в статье Службы интеграции. |

| Изменение размера окна VMConnect | Вы можете изменить размер окна VMConnect для виртуальных машин 2-го поколения, работающих под управлением операционной системы Windows. Для этого может потребоваться включить режим расширенного сеанса на узле Hyper-V. Дополнительные сведения см. в разделе . Сведения о виртуальных машинах под управлением Ubuntu см. в статье Changing Ubuntu Screen Resolution in a Hyper-V VM (Изменение разрешения экрана Ubuntu на виртуальной машине Hyper-V). |

Плюсы и минусы ядра Hyper-V

Как и в любом другом случае, существуют плюсы и минусы, которые необходимо учитывать при рассмотрении вопроса об использовании установок Hyper-V Core в вашей рабочей среде. Давайте посмотрим на них.Плюсы

В контексте Hyper-V есть много плюсов, когда речь заходит о запуске вашей рабочей инфраструктуры Hyper-V. Это включает в себя:

- Более легкая версия Windows

- Меньше » вздутия живота”

- Легче управлять

- Меньше исправлений

- Лучшая безопасность

Для производственных виртуальных машин уже давно рекомендуется запускать производственную инфраструктуру с использованием ядра Windows Server Core. Хотя многие клиенты, возможно, воздерживались от этого из-за трудностей в управлении средой, с помощью центра администрирования Windows и совместимости приложений Feature on Demand эти проблемы больше не актуальны.

Дополнительные Плюсы:

- Управление графическим интерфейсом через Центр администрирования Windows

- Возможность локального управления Windows Server Core с помощью средств управления FoD, установленных локально на сервере Windows Server Core

Минусы

Когда дело доходит до минусов, с новыми возможностями, найденными в Windows Server 2019 наряду с новыми инструментами управления, их немного. Однако в основном они сводятся к простоте управления. Даже с новыми инструментами все еще существует кривая обучения, которую необходимо преодолеть в большинстве сред, которые все еще используют только Windows Server с установкой Desktop Experience.

- Многим по-прежнему будет сложнее управлять ядром Hyper-V

- Новый Центр администрирования Windows представляет собой новый инструмент, требующий кривой обучения

- Функция по требованию-совместимость приложений-это дополнительное программное обеспечение, которое должно быть установлено на ваших серверах Hyper-V Core

![Iscsi подключение к схд сервера под windows [colobridge wiki]](http://tehnikaarenda.ru/wp-content/uploads/6/a/5/6a5d9680fff10332f7f46fa4bd65c10d.jpeg)

![Iscsi подключение к схд сервера под windows [colobridge wiki]](http://tehnikaarenda.ru/wp-content/uploads/1/5/e/15e8c473122005fefb649e72345d1c79.jpeg)